在开始前:

我在大二上学习概率论时,我曾经对事件的独立性的描述感到奇怪,书上仅描述了事件组之间相互独立的性质上的结论,却没有式子来刻画更本质的因果和独立性的传递,还追问了老师很久,最好不了了之,没有发现因果科学。

没想到,阴差阳错下有机会学习因果科学,弥补心中的遗憾。笔者认为,这是一门直指世界本质的,值得一学的伟大科学。

为什么——因果科学

0. 思维胜于数据

对于没有概率统计基础的读者来说,笔者的阅读建议是略过数学细节,着重抓住内容大意;

而对于有一定概率统计基础的读者来说,笔者认为在阅读时一定不能放过正文中的数学精髓,这本书中的数学公式不多不少,刚好自圆其说。

【读者有感,可以先看看第十章对数据挖掘和因果的讨论】

本书目标:

首先,用非数学的语言阐述因果革命的知识内涵,说明它将怎样影响我们的生活和未来。

其次,分享在解决重要的因果问题时,我们的科学家前辈走过的英勇征程,无论成败,这些故事都值得讲述。

最后,回溯因果革命在人工智能领域的发源地,目的是向你介绍如何开发出用我们的母语——因果语言进行交流的机器人。新一代机器人应该能够向我们解释事情为何发生,为何机器人以它们选择的某种方式做出反应,以及大自然为何以这样而非那样的方式运作。一个更加雄心勃勃的目标是,它们也应该能够让我们进一步认识人类自身:我们的思维为什么以这样的方式运行,以及理性思考原因和结果、信任和遗憾、目的和责任究竟意味着什么。

what is 因果推断:

它假设人类大脑是大自然有史以来为处理因果知识而设计出的最先进的工具。我们的大脑存储了海量的因果知识,而在数据的辅助下,我们可以利用这些知识解决当代社会所面临的最紧迫的问题。一个更宏伟的目标是,一旦我们真正理解了因果思维背后的逻辑,我们就可以在现代计算机上模拟它,进而创造出一个“人工科学家”。这个智能机器人将会为我们发现未知的现象,解开悬而未决的科学之谜,设计新的实验,并不断从环境中提取更多的因果知识。

这门新科学催生出了一种简单的数学语言,用以表达我们已知和欲知的因果关系。以数学形式表达因果关系的能力让我们得以开发出许多强大的、条理化的方法,将我们的知识与数据结合起来,并最终回答出如上述那5个涉及因果关系的问题。

why too late:

在我看来,阻碍因果推断这一科学诞生的最大障碍,是我们用以提出因果问题的词汇和我们用以交流科学理论的传统词汇之间的鸿沟。

科学工具的开发是为了满足科学需要。

随着人类求知欲的不断增强,以及社会现实开始要求人们讨论在复杂的法律、商业、医疗等领域的决策情境中出现的因果问题,我们终于发现我们缺少一门成熟的科学所应提供的用于回答这些问题的工具和原理。

具有讽刺意味的是,对因果关系理论的需求正是在统计学产生的那一刻浮出水面的。事实上,现代统计学的创立正源自因果问题——高尔顿和皮尔逊提出了一个关于遗传的因果问题,并独具匠心地尝试用跨代数据来解答它。遗憾的是,这一努力失败了,他们没有停下来问为什么,反而声称这些问题是禁区,转而去发展另一项刚刚兴起、不涉及因果关系的事业——统计学。

这是科学史上的一个关键时刻。给因果问题配备一套专属语言的机会眼看就要被成功捕捉并转化为现实,却被白白浪费掉了。在接下来的几年里,这些问题被宣布为“非科学”,被迫转入地下。尽管遗传学家休厄尔·赖特(1889—1988)为此做出了艰苦卓绝的努力,但因果词汇仍然被科学界禁用了半个多世纪。我们知道,禁止言论就意味着禁止了思想,同时也扼杀了与此相关的原则、方法和工具。【第二章】

统计学盲目迷恋这种常识性的观察结论。它告诉我们,相关关系不等于因果关系,但并没有告诉我们因果关系是什么。在统计学教科书的索引里查找“因果”这个词是徒劳的。统计学不允许学生们说X是Y的原因[2],只允许他们说X与Y“相关”或“存在关联”。

这一禁律也潜移默化地让人们认同了处理因果问题的数学工具毫无用武之地这一结论,与此同时,统计学唯一关注的就是如何总结数据,而不关注如何解释数据。

【纯粹数据driven的局限】

统计学的其他分支,以及那些依赖统计学工具的学科仍然停留在禁令时代,错误地相信所有科学问题的答案都藏于数据之中,有待巧妙的数据挖掘手段将其揭示出来。

今天,这种以数据为中心的观念仍然阴魂不散。我们生活在一个相信大数据能够解决所有问题的时代。大学中“数据科学”方面的课程激增,在涉足“数据经济”的公司中,“数据科学家”享有极高的工作待遇。然而,我希望本书最终能说服你相信这一点:数据远非万能。数据可以告诉你服药的病人比不服药的病人康复得更快,却不能告诉你原因何在。也许,那些服药的人选择吃这种药只是因为他们支付得起,即使不服用这种药,他们照样能恢复得这么快。

在科学和商业领域,仅凭数据不足以解决问题的情况一再发生。尽管或多或少地意识到了其局限所在,但多数热衷于大数据的人仍然选择盲目地继续追捧以数据为中心的问题解决方式,仿佛我们仍活在因果禁令时代。

在20年前,询问一个统计学家诸如“是阿司匹林治愈了我的头痛吗”这样的问题还会被视为在问他是否相信巫术。引用我的一位备受尊敬的同事的话,讨论这种问题“与其说是科学探索,不如说是鸡尾酒会上的八卦闲谈”。但今天,流行病学家、社会学家、计算机科学家以及一些开明的经济学家和统计学家开始频繁地提出这样的问题,并能够借助具有高度精确性的数学工具作答。对我来说,这种改变就是一场革命。

(感觉因果科学是对现有相关框架的弥补,而不是对数据驱动的完全否定)

数学工具

它背后有数学工具上的发展作为支撑,这种数学工具最恰当的名称应该是“因果关系演算法”

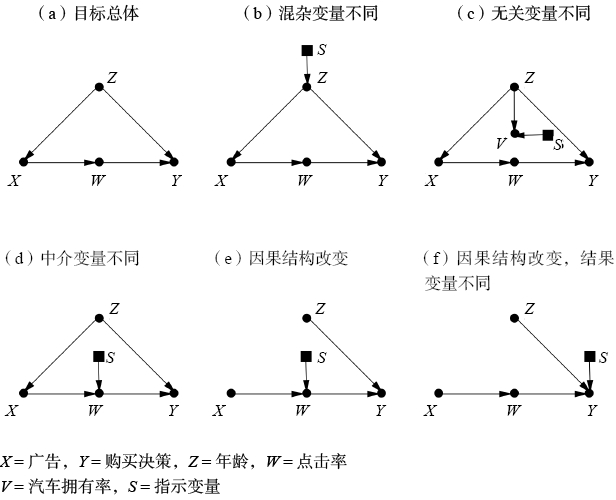

因果关系演算法由两种语言组成:其一为因果图(causal diagrams),用以表达我们已知的事物,其二为类似代数的符号语言,用以表达我们想知道的事物。因果图是由简单的点和箭头组成的图,它们能被用于概括现有的某些科学知识。点代表了目标量,我们称之为“变量”,箭头代表这些变量之间已知或疑似存在的因果关系,即哪个变量“听从于”哪个变量。

有些科学家(比如计量经济学家)喜欢使用数学方程;另一些研究者(比如纯统计学家)则更倾向于借助一组假设来描述问题,这些假设表象化地概括了因果图的关系结构。不管使用哪种语言,因果模型都应该描述,哪怕是定性地描述数据的生成过程,换句话说,就是那些在环境中控制并塑造数据生成的因果力量。

与图表式的“知识语言”并存的还有一种符号式的“问题语言”,它被用于表述我们想要回答的问题。do算子表明了我们正在进行主动干预而非被动观察,这一概念是经典统计学不可能涉及的。

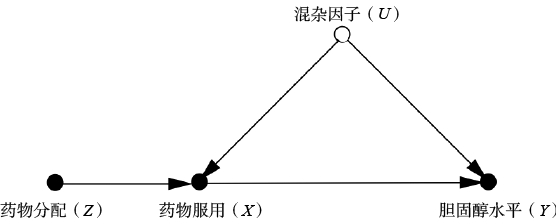

An example

干预算子do(D)来确保观察到的病人存活期L的变化能完全归因于药物本身,而没有混杂其他影响寿命长短的因素。如果我们不进行干预,而是让病人自己决定是否服用该药物,那么其他因素就可能会影响病人的决定,而服药和未服药的两组病人的存活期差异也将无法再被仅仅归因于药物。

假设只有疾病发展到末期的病人服用了这种药,那么这些人的情况就显然不同于那些不服药的病人,两组的比较结果实际上反映的是其病情的严重程度,而非药物的影响。

相比之下,随机地指示一些病人服用药物或不服用药物,而不考虑先决条件如何,则可以去除两组病人之间原有的差异,提供有效的比较结果。

注意P(L|D)与P(L|do(D))完全不同。观察到(seeing)和进行干预(doing)有本质的区别,它解释了我们不认为气压计读数下降是风暴来临的原因。

观察到气压计读数下降意味着风暴来临的概率增加了,但人为迫使气压计读数下降对风暴来临的概率并不会产生影响。

对观察和干预的混淆成为悖论之源,对此本书将展开详细的讨论。缺少P(L|do(D)),而完全由P(L|D)统治的世界将是十分荒诞的。在这个世界中,病人不去就诊就能减少人们患重病的概率,城市解雇消防员就能减少火灾的发生

因果革命最重要的成果之一就是解释了如何在不实际实施干预的情况下预测干预的效果。

反事实(counterfactual)

经典统计学只关注总结数据,因此它甚至无法提供一种语言让我们提出上面那个问题。因果推断则不仅提供了一种表达符号,更重要的是,它还提供了一种解决方案。这使得我们在预测干预效果时,在多数情况下能够借助一种算法来模拟人类的反思性思考,通过将我们对观测世界的了解输入算法系统,其将输出有关反事实世界的答案。

反事实并非异想天开之物,而是反映了现实世界运行模式的特有结构。共享同一因果模型的两个人也将共享所有的反事实判断。

反事实是道德行为和科学思想的基石。回溯自己过去的行为以及设想其他可能情景的能力是自由意志和社会责任的基础。反事实的算法化使“思维机器”(thinking machine)习得这种人类特有的能力,并掌握这种目前仍为人类所独有的思考世界的方式成为可能。

20世纪80年代末,我意识到智能机器缺乏对因果关系的理解,这也许是妨碍它们发展出相当于人类水平的智能的最大障碍。我坚信强人工智能是一个可实现的目标,也是一个完全无须恐惧的目标,因为我们在实现它的过程中纳入了因果关系。因果推理模块将使智能机器有能力反思它们的错误,找到自身软件程序中的弱点,并能像一个道德实体那样思考和行动,自然地与人类交流它们自己的选择和意图。

因果模型

因果模型将科学、知识、数据这些晦涩的概念纳入了一个具体的、有意义的背景框架,让我们得以看到三者是如何相互协作以解答棘手的科学问题的。

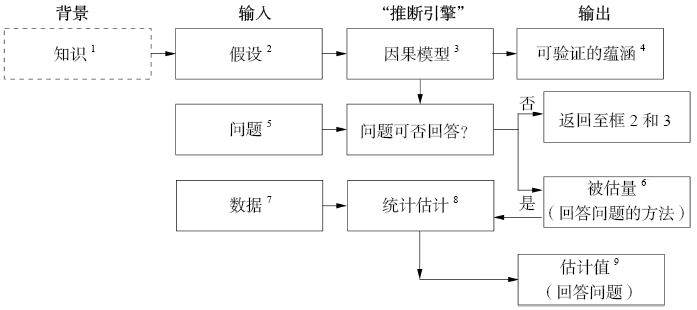

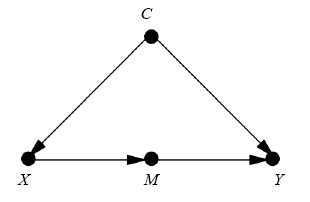

因果推断引擎是一种问题处理机器,它接收三种不同的输入——假设、问题和数据,并能够产生三种输出。能够将数据与因果知识相结合生成目标问题的答案。(虚线框不是引擎的组成部分,但它是构建引擎的必要基础。箭头也可以从方框4和方框9指向方框1,也即是把答案添加到已有的知识中去)

第一种输出是“是/否”判断,用于判定在现有的因果模型下,假设我们拥有完美的、无限的数据,那么给定的问题在理论上是否有解。

如果答案为“是”,则接下来推断引擎会生成一个被估量。这是一个数学公式,可以被理解为一种能从任何假设数据中生成答案的方法,只要这些数据是可获取的。

最后,在推断引擎接收到数据输入后,它将用上述方法生成一个问题答案的实际估计值,并给出对该估计值的不确定性大小的统计估计。这种不确定性反映了样本数据集的代表性以及可能存在的测量误差或数据缺失。

1.“知识”指的是推理主体(reasoning agent)过去的经验,包括过去的观察、以往的行为、接受过的教育和文化习俗等所有被认为与目标问题有关的内容。“知识”周围的虚线框表示它仍隐藏在推理主体的思想中,尚未在模型中得到正式表达!

2.研究者所拥有的大部分知识都隐藏于他的大脑,只有假设能将其公之于世,也只有假设才能被嵌入模型。

4.以因果模型的路径来表示的变量之间的听从模式通常会导向数据中某种显而易见的模式或相关关系。这些模式可被用于测试模型,因此也被称为“可验证的蕴涵”(testable implications)。将“D和L之间没有连接路径”翻译成统计学语言,就是“D和L相互独立”,也就是说,发现D的存在不会改变L发生的可能性。而如果实际数据与这一推断相抵触,那么我们就需要修改模型。此类修改涉及另一个引擎,它从方框4和方框7中获取输入,并计算模型的“拟合度”,即数据与模型假设的匹配程度。为尽可能简化示意图起见,我没有在图0.1中表示出这个引擎。

在命题逻辑和谓词逻辑中,蕴涵这一概念用于描述两个陈述语句集合之间的联系(离散那个概念)

5.向推理引擎提交的问题就是我们希望获得解答的科学问题,这一问题必须用因果词汇来表述。例如,我们现在感兴趣的问题是:P(L|do(D))是什么?因果革命的主要成就之一就是确保了这一语言在科学上容易理解,同时在数学上精确严谨。

6.被估量“estimand”来自拉丁语,意思是“需要估计的东西”。它是我们从数据中估算出来的统计量。一旦这个量被估算出来,我们便可以用它来合理地表示问题的答案。虽然被估量的表现形式是一个概率公式,如P(L|D,Z)×P(Z),但实际上它是一种方法,可以让我们根据我们所掌握的数据类型回答因果问题(前提是推断引擎证实了这种数据类型就是我们需要的)

与传统的统计学所提供的估计方法不同,在当前的因果模型下,无论我们收集到多少数据,有些问题可能仍然无法得到解答。例如,如果我们的模型显示D和L都依赖于第三变量Z(比如疾病的发展阶段),并且,如果我们没有任何方法可以测量Z的值,那么问题P(L|do(D))就无法得到解答。在这种情况下,收集数据完全就是浪费时间。相反,我们需要做的是回过头完善模型,具体方式则是输入新的科学知识,使我们可以估计Z的值,或者简化假设(注意,此处存在犯错的风险),例如假设Z对D的影响是可以忽略不计的。(看完第二章的例子就懂了)

:star: 7.一定要认识到,数据本身不具备表述因果关系的能力。数据告诉我们的只是数量信息,如P(L|D)或P(L|D,Z)的值。而被估量则能够告诉我们如何将这些统计量转化为一个表达式。基于模型假设,该表达式在逻辑上等价于我们所要回答的因果问题,比说P(L|do(D))。

被估量这个概念以及图0.1顶部的所有概念在统计分析的传统方法中都是不存在的。在传统的统计方法中,被估量就等同于有待解决的问题。

8.你已经得到了一个新鲜出炉的估计值。不过,它只是一个近似值,其原因涉及关于数据的另一个真相:数据永远是从理论上无限的总体中抽取的有限样本。即使这种筛选是随机的,我们也无法避免根据样本测量的概率无法代表整个总体的相应概率的可能性。幸运的是,依靠机器学习领域所提供的先进技术,统计学科为我们提供了很多方法来应对这种不确定性,这些方法包括最大似然估计、倾向评分、置信区间、显著性检验等

请注意,我们是在完成了以下步骤之后才收集的数据:根据假设确定了因果模型,提出了我们想要解决的科学问题,推导出被估量。这与上面提到的传统统计方法形成了鲜明对比,后者甚至没有用到因果模型。

【许多人工智能领域的研究者仍然想跳过构建因果模型或识别出已有的因果模型这一难度较大的步骤,只依赖数据解决所有的认知难题。他们希望在因果问题出现时,数据本身就能指引他们找到正确的答案】

但对于因果关系方面的知识来说,数据没有任何发言权。例如,有关行动或干预结果的信息根本无法从原始数据中获得,这些信息只能从对照试验操作中收集。

因果模型所具备而数据挖掘和深度学习所缺乏的另一个优势就是适应性。注意在图0.1中,被估量是在我们真正检查数据的特性之前仅仅根据因果模型计算出来的,这就使得因果推断引擎适应性极强,因为无论变量之间的数值关系如何,被估量都能适用于与定性模型适配的数据。

通过观察许多服用药物D的患者的存活期L,某研究者能够预测出某个具有Z特征的病人存活L年的概率。现在,假设她被调职到位于城市另一地区的医院,而那里的人口总体特征(饮食、卫生、工作习惯)与原来的地区有所不同。即使这些新特性仅仅改变了以前她所记录的变量之间的数值关系,她仍不得不重新自我训练,再次从头学习新的预测函数。这就是深度学习程序所能做的:将函数与数据拟合。

而如果该研究者掌握了药物的作用机制,并且新地区的因果模型结构仍与原来保持一致,那么她在以往的训练中获得的被估量就依然有效,可被应用于新数据,产生一个新的关于特定总体的预测函数。

贝叶斯网络是让计算机得以在“灰色地带”进行思考的第一个工具,有段时期,我曾坚信它掌握着开启人工智能大门的钥匙。而到了20世纪80年代末,我终于确信自己错了,本章讲述的正是我从贝叶斯倡导者变身为“叛教者”的整段旅程。不过,贝叶斯网络仍然是人工智能领域的一个非常重要的工具,其涵盖了因果图的大部分数学基础。

这些悖论是一种警示,用以提醒科学家们人类的直觉是根植于因果的,而不是根植于统计和逻辑的。

如果能用一句话来概括本书的内容,那就是“你比你的数据更聪明”。数据不了解因果,而人类了解。我希望因果推断这门新科学能让我们更好地理解我们是如何做到这件事的,因为除了自我模拟,我们没有更好的方法来了解人类自身了。与此同时,在计算机时代,这种新的理解也有望被应用于增强人类自身的因果直觉,从而让我们更好地读懂数据,无论是大数据还是小数据。

(感觉要读懂,就得破除思想中对客观数据的迷信,更何况数据本身也可能是不客观的。)

1. 因果关系之梯

- 首先,人类在进化早期就意识到世界并非由枯燥的事实(我们今天可能称之为数据)堆砌而成;相反,这些事实是通过错综复杂的因果关系网络融合在一起的。

- 其次,因果解释而非枯燥的事实构成了我们大部分的知识,它应该成为机器智能的基石!!

- 最后,我们从数据处理者向因果解释者的过渡不是渐进的,而是一次“大跃进”,借助的是某种奇异的外部推力。这与我在因果关系之梯上的理论观察完全吻合:没有哪台机器可以从原始数据中获得解释。对数据的解释需要借助外部推力。

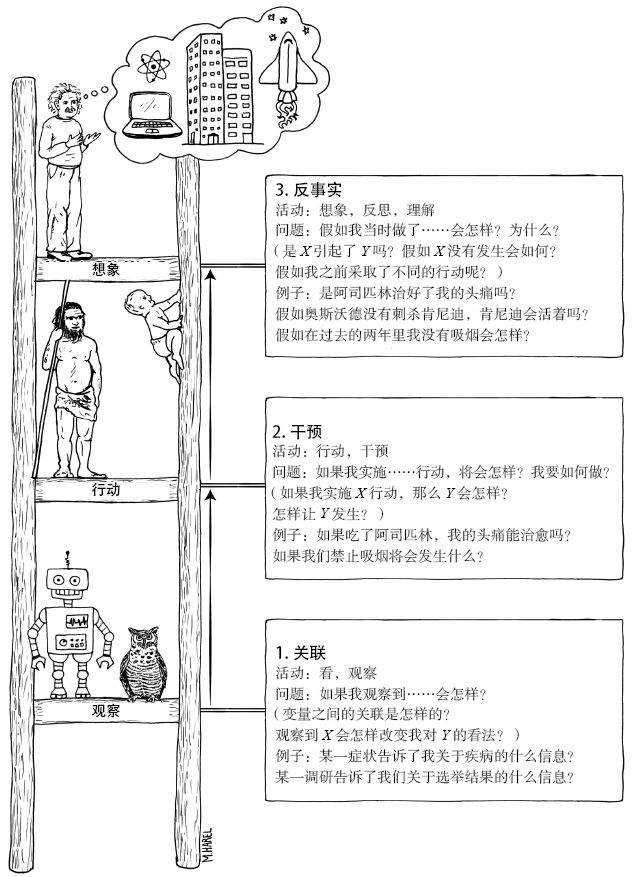

因果关系的三个层级

可能大家会觉得,我们将关于这个世界的知识组织起来融入因果关系网络的能力是一种一体化的能力,是可以一下子学会或领悟的。

事实上,我在机器学习方面的研究经历告诉我,因果关系的学习者必须熟练掌握至少三种不同层级的认知能力:

观察能力(seeing)、行动能力(doing)和想象能力(imagining)。

第一层级是观察能力,具体而言是指发现环境中的规律的能力。在认知革命发生之前,这种能力为许多动物和早期人类所共有。

第二层级是行动能力,涉及预测对环境进行刻意改变后的结果,并根据预测结果选择行为方案以催生出自己期待的结果。

处于第一层级的是关联,在这个层级中我们通过观察寻找规律。如果观察到某一事件改变了观察到另一事件的可能性,我们便说这一事件与另一事件相关联。因果关系之梯的第一层级要求我们基于被动观察做出预测。其典型问题是:“如果我观察到……会怎样?”

统计学本身并不能告诉我们,牙膏或牙线哪个是因,哪个是果。好的预测无须好的解释。

强人工智能这一目标是制造出拥有类人智能的机器,让它们能与人类交流并指导人类的探索方向。而深度学习只是让机器具备了高超的能力,而非智能。这种差异是巨大的,原因就在于后者缺少现实模型

当我们开始改变世界的时候,我们就迈上了因果关系之梯的更高一层台阶。这一层级的一个典型问题是:“如果我们把牙膏的价格翻倍,牙线的销售额将会怎么样?”这类问题处于因果关系之梯的第二层级,提出及回答这类问题要求我们掌握一种脱离于数据的新知识,即干预。

无论数据集有多大或者神经网络有多深,只要使用的是被动收集的数据,我们就无法回答有关干预的问题。从统计学中学到的任何方法都不足以让我们明确表述类似“如果价格翻倍将会发生什么”这样简单的问题,更别说回答它们了。

为什么不直接进入存有历史购买信息的庞大数据库,看看在牙膏价格翻倍的情况下实际发生了什么呢?原因在于,在以往的情况中,涨价可能出于完全不同的原因,例如产品供不应求,其他商店也不得不涨价等。但现在,我们并不关注行情如何,只想通过刻意干预为牙膏设定新价格,因而其带来的结果就可能与此前顾客在别处买不到便宜牙膏时的购买行为大相径庭。如果你有历史行情数据,也许你可以做出更好的预测……但是,你知道你需要什么样的数据吗?你准备如何理清数据中的各种关系?这些正是因果推断科学能帮助我们回答的问题。

:star: 一个足够强大的、准确的因果模型可以让我们利用第一层级(关联)的数据来回答第二层级(干预)的问题。没有因果模型,我们就不能从第一层级登上第二层级。这就是深度学习系统(只要它们只使用了第一层级的数据而没有利用因果模型)永远无法回答干预问题的原因,干预行动据其本意就是要打破机器训练的环境规则。

因果关系之梯第二层级的典型问题就是:“如果我们实施……行动,将会怎样?”也即,如果我们改变环境会发生什么?第二层级中的另一个热门问题是:“怎么做?”

反事实与数据之间存在着一种特别棘手的关系,因为数据顾名思义就是事实。数据无法告诉我们在反事实或虚构的世界里会发生什么,在反事实世界里,观察到的事实被直截了当地否定了。然而,人类的思维却能可靠地、重复地进行这种寻求背后解释的推断。

你可能会怀疑,对于“假如”(would haves)这种并不存在的世界和并未发生的事情,科学能否给出有效的陈述。科学确实能这么做,而且一直就是这么做的。举个例子,“在弹性限度内,假如加在这根弹簧上的砝码重量是原来的两倍,弹簧伸长的长度也会加倍”(胡克定律),像这样的物理定律就可以被看作反事实断言。当然,这一断言是从诸多研究者在数千个不同场合对数百根弹簧进行的实验中推导出来的,得到了大量试验性(第二层级)证据的支持。然而,一旦被奉为“定律”,物理学家就把它解释为一种函数关系,自此,这种函数关系就在假设中的砝码重量值下支配着某根特定的弹簧。所有这些不同的世界,其中砝码重量是x磅[1],弹簧长度是Lx英寸[2],都被视为客观可知且同时有效的,哪怕它们之中只有一个是真实存在的世界。

假如当时发生的事情与实际不同,那会怎样?”对这个问题的回答让我们得以从历史和他人的经验中获取经验教训,这是其他物种无法做到的。

:star: 如果第一层级对应的是观察到的世界,第二层级对应的是一个可被观察的美好新世界,那么第三层级对应的就是一个无法被观察的世界(因为它与我们观察到的世界截然相反)

迷你图灵测试

在创造出具备孩童智能水平的机器人之前,我们可能的确无法成功创造出类人智能,而创造出前者的关键要素就是掌握因果关系。

机器如何才能获得关于因果关系的知识呢?目前,这仍然是一项重大挑战,其中无疑会涉及复杂的输入组合。这些输入来自主动实验、被动观察和(最关键的)程序员输入,这与儿童所接收的信息输入非常相似,他们的输入分别来自进化、父母和他们的同龄人(对应于程序员这个角色)

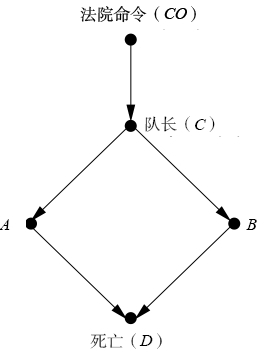

“迷你图灵测试”,其主要思路是选择一个简单的故事,用某种方式将其编码并输入机器,测试机器能否正确回答人类能够回答的与之相关的因果问题。之所以称其为“迷你”,原因有二。首先,该测试仅限于考察机器的因果推理能力,而不涉及人类认知能力的其他方面,如视觉和自然语言。其次,我们允许参赛者以任何他们认为便捷的表示方法对故事进行编码,这就免除了机器必须依据其自身经验构造故事的任务。让智能机器通过这个迷你测试是我毕生的事业——在过去的25年里是自觉而为,在那之前则是无意而为。

在让机器进行迷你图灵测试的准备阶段,表示问题必须优先于获取问题。如果缺少表示方法,我们就不知道如何存储信息以供将来使用。人工智能对认知研究的一个主要贡献就是确立“表示第一,获取第二”的范式。通常,在寻求一个好的表示方法的过程中,关于如何获取知识的洞见就会自然产生,无论这种洞见是来自数据,还是来自程序员。

作弊是困难的,假设我们有10个因果变量,每个变量只取两个值(0或1),那么我们可以提出大约3000万个关于这些变量的可能问题

人类的大脑肯定拥有某种简洁的信息表示方式,同时还拥有某种十分有效的程序用以正确解释每个问题,并从存储的信息表示中提取正确答案。因此,为了通过迷你图灵测试,我们需要给机器装备同样高效的表示信息和提取答案的算法。

这种表示不仅存在,而且具有孩童思维般的简洁性,它就是因果图。如果我们希望计算机能理解因果关系,我们就必须教会它如何打破规则,让它懂得“观察到某事件”和“使某事件发生”之间的区别。“无论何时,如果你想使某事发生,那就删除指向该事的所有箭头,之后继续根据逻辑规则进行分析..(中间)

使某事发生就意味着将它从所有其他影响因子中解放出来,并使它受限于唯一的影响因子——能强制其发生的那个因子。

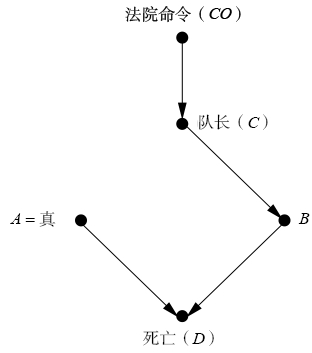

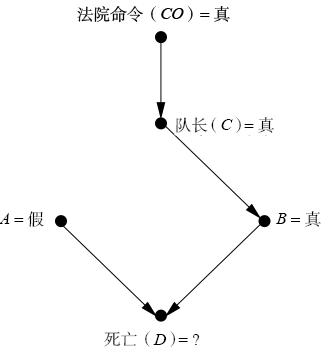

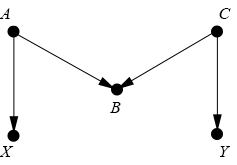

假如A决定不开枪,犯人是否还活着?在虚构世界中,A没有射击,指向A的箭头被去除,这进而又解除了A与C的听命关系。现在,我们将A的值设置为假,并让A行动之前的所有其他变量的水平与现实世界保持一致。(右图)

在许多情境中,人类可能需要花费很大的努力才能找到那个正确的因果结论。定量的因果推理通常超出了我们的直觉范畴。此外,为了处理不确定因素,我们就需要掌握有关异常事件发生可能性的信息。【引入概率】

从计算的角度来看,我们设计出的这种让机器通过迷你图灵测试的方案也很出色。在所有三个例子中,我们都使用了相同的程序:

将故事转化成因果图,解读问题,执行与既定问题(干预问题或反事实问题)相对应的“手术”(如果问题是关联类的,则不需要进行任何“手术”),并使用修改后的因果模型计算答案。

并且,每次改变故事的时候,我们也不必根据各种新的问题重新训练机器。这一方法具有足够的灵活性,只要我们能绘制出因果图,我们就能解决问题,无论这个问题是关乎长毛象狩猎、行刑队执行枪决还是关乎疫苗接种。这正是我们希望因果推断引擎具备的特性:一种为人类所独享的灵活性。

这些变化将对前文提到的例子中的绝大部分变量的概率产生极大的影响;但显然,原有的因果图结构仍将保持不变。这正是构建因果模型的关键秘诀。此外,一旦我们完成了之前的分析工作,我们就不必在条件改变时从头开始重复整个分析过程。如导言所述,同样的被估量(也就是回答相应问题的方法)将一直有效,并且只要因果图不变,该被估量就可以应用于新数据,并为特定问题生成新的估计值。我猜想,正是由于具备这种稳健性,人类的直觉才以因果关系而非统计关系为组织的核心。

论概率与因果关系

哲学家几乎无一例外地使用了条件概率来表示“X提高了Y的概率”,记作P(Y|X)>P(Y)。你肯定注意到了,这种解释是错的,因为“提高”是一个因果概念,意味着X对Y的因果效应,而公式P(Y|X)>P(Y)只涉及观察和手段,表示的是“如果我们观察到了X,那么Y的概率就提高了”。但是,这种概率提高完全可能是由其他因素造成的,比如Y是X的因,或者其他变量(Z)是它们二者的因——这就是症结所在!

一旦用条件概率的语言歪曲“概率提高”,即使再多的概率补丁也无法让你登上更高一层的因果关系阶梯。我知道这听起来很奇怪,但概率提高这个概念确实不能单纯用概率来表示。

拯救概率提高这一概念的正确方法是借助do算子来定义:如果P(Y|do(X))>P(Y),那么我们就可以说X导致了Y。由于干预是第二层级的概念,因此这个定义能够体现概率提高的因果解释,也可以让我们借助因果图进行概率推算。换言之,当研究者询问是否P(Y|do(X))>P(Y)时,如果我们手头有因果图和数据,我们就能够在算法上条理清晰地回答他的问题,从而在概率提高的意义上判断X是否为Y的一个因。

我并非一直把因果放在第一位,把概率放在第二位。恰恰相反!20世纪80年代初,我开始踏足人工智能方面的研究,并认定不确定性正是人工智能缺失的关键要素。此外,我坚持不确定性应由概率来表示。因此,正如我将在第三章中解释的那样,我创建了一种关于不确定性的推理方法,名为“贝叶斯网络”,用于模拟理想化的、去中心化的人类大脑将概率纳入决策的方法。贝叶斯网络可以根据我们观察到的某些事实迅速推算出某些其他事实为真或为假的概率。不出所料,贝叶斯网络立即在人工智能领域流行开来,甚至直至今天仍被视为人工智能在包含不确定性因素的情况下进行推理的主导范式。

但它并没能弥合人工智能和人类智能之间的差距。我相信你现在也能找出那个缺失的要素了——没错,就是因果论。

当时我认为因果关系只是一个从属概念,最多不过是一种便利的思维工具或心理速记法,用以表达概率的相关性以及区分相关变量和无关变量(好有道理)

贝叶斯网络适用于一个所有问题都被简化为概率或者(用本章的术语来说就是)变量间的关联程度的世界,它无法自动升级到因果关系之梯的第二层级或第三层级。

我想说明的主要观点是:概率能将我们对静态世界的信念进行编码,而因果论则告诉我们,当世界被改变时,无论改变是通过干预还是通过想象实现的,概率是否会发生改变以及如何改变。

2. 因果推断的起源

——从海盗(皮尔逊)到豚鼠

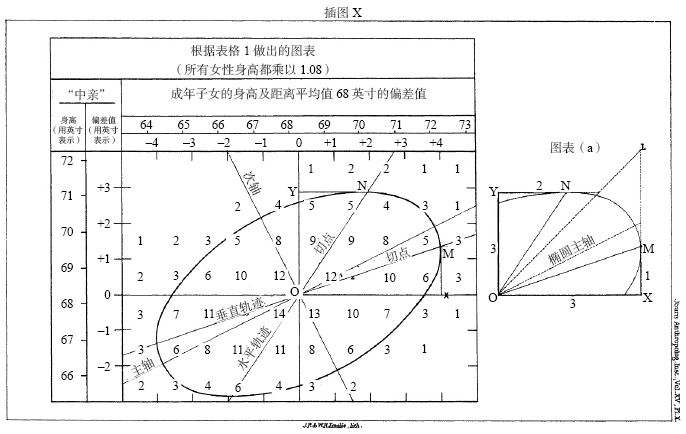

对高尔顿来说,梅花机就是一种关于身高遗传的模型,甚至可能也是关于许多其他遗传特征的模型。这是一个因果模型。简单来说,高尔顿相信,就像人类会遗传他们上一代的身高一样,金属小球也会“遗传”它们在梅花机中的位置。

但是,如果我们暂且接受这个模式,就会出现一个难题,这也是高尔顿当晚的主题。钟形曲线的宽度取决于放置在钉板顶部和底部之间钉子的行数。假设我们将行数加倍,我们就构建了一个能够表示两代遗传的模型,其中上半部分代表第一代,下半部分代表第二代。此时你就会发现,第二代比第一代出现了更多的变异情况,而在随后的几代中,钟形曲线会变得越来越宽。

然而,人类身高的真实状况并未出现此种趋势。

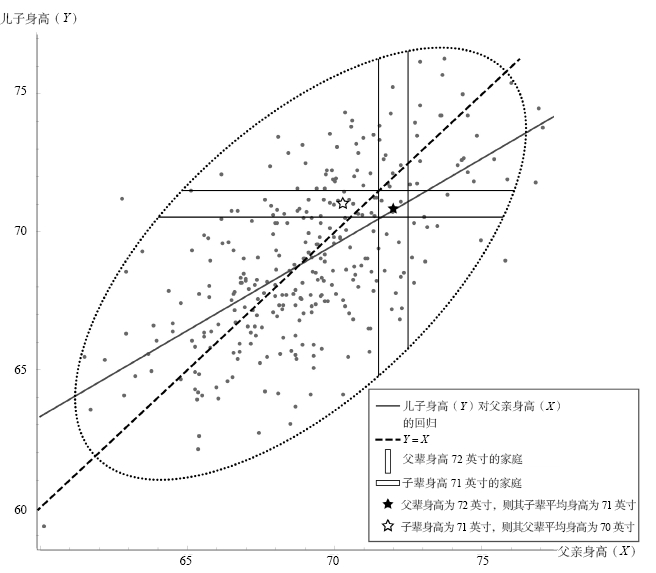

高尔顿在此过程中还是有所发现的,特别是当他开始关注类似身高这样的遗传特征的时候。与“卓越”相比,身高特征更易测量,跟遗传的关联也更强。高个子男性的儿子往往身高也比普通人高——但很可能不如他们的父辈高;矮个子男性的儿子往往身高比一般人矮——但很可能不如他们的父辈矮。一开始,高尔顿称这种现象为“复归”(reversion),后又改称为“向均值回归”(regression toward mediocrity)(regression也有退化的意思)。

散点图分析:

分析每一个垂直框,预测总是落在一条直线上,他称这条直线为回归线,它比椭圆的主轴(或对称轴)的斜率小(见图2.3)。事实上,这样的直线有两条,我们选择哪条线作为回归线取决于我们要预测哪个变量而将哪个变量作为证据。

表明,对于向均值回归这一现象,因和果是没有区别的。

如果你知道父亲的身高,则直线OM将为你提供其儿子身高的最佳预测;如果你知道儿子的身高,则直线ON将为你提供其父亲身高的最佳预测。这两条直线都不同于散点图中的主轴(对称轴)

相关性概念首次在不依赖于人的判断或解释的前提下以客观度量说明了两个变量是如何关联的。找到这样一种通用的方式来描述随机变量之间的关系,高尔顿和皮尔逊一定曾为此激动不已。尤其是皮尔逊,在他的眼中,与相关系数这种在数学上清晰且精确的概念相比,那些关于因果的模糊而陈旧的概念似乎已经完全过时而丧失科学性了。

高尔顿以寻找因果关系为起点,最终却发现了相关性——一种无视因果的关系。这是一段颇具讽刺意味的历史。

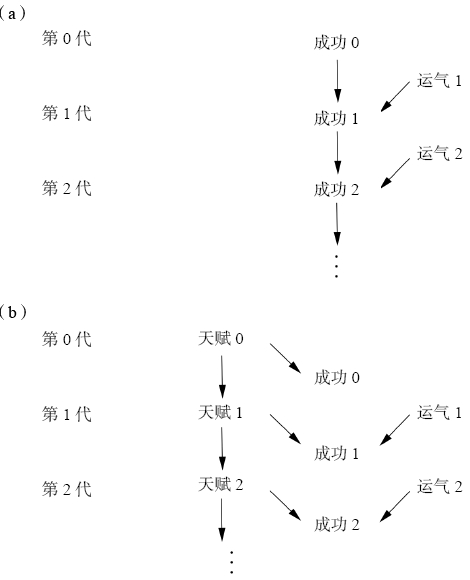

小球在下一层的位移继承了其沿路撞到的所有钉子带给它的变化的总和。这就与卡尼曼的方程产生了明显的矛盾:

成功=天赋+运气

巨大的成功=更多的天赋+更多的运气

根据卡尼曼的方程,第二代的成功不会继承第一代的运气。按其定义,运气本身是一个只具有短暂影响的事件,因此其对后代没有影响。然而这一具有短暂影响的事件与高尔顿的梅花机是不兼容的。

为将这两个概念放在一起比较,让我们试着画出相应的因果图。

(a)高尔顿板模型,在这种模型下,运气世代相传,这就导致成功的分布不断变宽。(b)遗传模型,在这种模型下,运气不会累积,这就导致成功在代际间的稳定分布

在皮尔逊的眼中,高尔顿扩展了科学的词汇。因果关系被简化为仅仅是相关关系的一个特例(在这一特例中,相关系数为1或–1,两个变量x和y之间的关系是确定的)。因果关系对于皮尔逊来说仅仅是一种重复,在确定性的意义上是永不可证的。数据就是科学的全部,因果关系之梯的最底层就是科学家进行科学研究所需的一切。

【皮尔逊带给我的启示:不要迷信权威的论文和观点,并奉为圭臬,比如batch_norm是好的,还是得自己阅读文献,看看作者的发现和对此的解释,独立思考。】

我们现在已经意识到了,在某些情况下,正确的分析结果只能来自聚合数据,而非来自分组数据。

莱特的分析方法

赖特开创的分析方法在他之后得到了极大的发展,其应用范畴远远超越了最初的豚鼠基因研究。

在寻求某个未知量的值时,你可以先赋予该量一个符号,然后用数学方程的形式描述你对该量和其他相关量的认识,最后,如果你有足够多的耐心和足够多的方程,你就可以解出方程式,并算出目标量的值。

许多人仍然会犯尼尔斯的错误,认为因果分析的目的只是证明X是Y的因或从头开始找到Y的因。这的确是因果关系研究中的因果发现难题,也是我第一次投身于图形化建模时雄心勃勃地试图解决的问题,直到现在,这依然是一个充满活力的研究领域。相比之下,赖特的研究重点,以及本书的讨论重点,则是用数学语言表达看似合理的因果知识,将其与经验数据相结合,回答具有实际价值的因果问题。

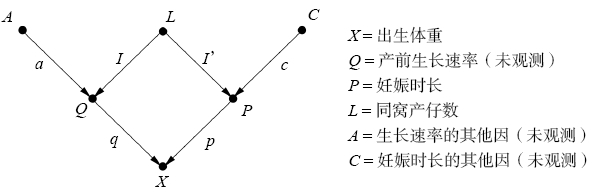

妊娠时长P对于出生体重X的直接效应是什么?【具体见书】

赖特的方法告诉我们如何用路径系数来表示每个需要测量的相关性。在对每组变量间的相关性(P,X)、(L,X)和(L,P)执行此操作之后,我们就会得到3个方程,并可以据此用代数方法求解未知路径系数p、l’以及l×q。然后问题就解决了,因为我们想要的路径系数p的值现在已经可以计算出来了。

第一个经验是:因果分析允许我们量化在现实世界中实际存在的某个过程,而非只能分析数据中的模式。

第二个经验是:无论是否采用数学处理,在路径分析中,你都能通过检查整个路径图得出关于单个因果关系的结论。而如果你想测算某个具体的路径系数,你可能就需要进一步分析路径图的整体结构了

因果分析绝不只是针对数据的分析;在因果分析中,我们必须将我们对数据生成过程的理解体现出来,并据此得出初始数据不包含的内容。但有一点费舍尔说得没错:一旦你从统计学中删除因果关系,那么剩下的就只有数据约简了。

贝叶斯连接——从客观性到主观性

赖特认为:“路径分析这种灵活的方法与为尽可能避免偏离客观性而设计的刻板的描述统计方法有很大的区别。”

这句话是什么意思?首先,赖特想说的是,路径分析的应用应该以研究者对因果过程的个人理解为基础,这种理解就反映在其所绘制的因果图或路径图中。它不能被简化为一个机械性的程序,就像统计手册里列出的那些操作方法一样。

1834年3月15日伦敦统计学会成立伊始,客观性就是统计学家的圣杯。学会的创始章程规定,在所有的情况下,数据都优先于观点和解释。数据是客观的,而观点是主观的。这个规则的提出远远早于皮尔逊时代。为客观性而奋斗,完全根据数据和实验进行推理的思想,自伽利略以来一直是科学定义自身存在方式的一部分。

与相关性分析和大多数主流统计学不同,因果分析要求研究者做出主观判断。研究者必须绘制出一个因果图,其反映的是他对于某个研究课题所涉及的因果过程拓扑结构的定性判断,或者更理想的是,他所属的专业领域的研究者对于该研究课题的共识。为了确保客观性,他反而必须放弃传统的客观性教条。在因果关系方面,睿智的主观性比任何客观性都更能阐明我们所处的这个真实世界。

【一时也有点难以接受,统计学家们希望寻找到一种通法、真理吗,再看看,保留一些疑惑】

在今天的统计学会议上,你已经不会再见到“贝叶斯学派”和“频率派”(frequentists)之间发生激烈辩论的情形,而在20世纪60年代和70年代,此类争论曾频繁爆发

贝叶斯分析的原型是这样的:先验判断+新的证据→经过修正的判断。例如,假设你抛掷10次硬币,发现其中有9次结果是正面朝上。那么此时你认为硬币抛掷是一个公平的游戏这一判断就可能会发生动摇,但你具体在多大程度上动摇了呢?一位正统的统计学家会说:“在没有任何额外证据的情况下,我倾向于认为这枚硬币掺有杂质,所以我敢打赌,下一次抛掷硬币时,硬币正面朝向的概率为9∶1。”

而一位贝叶斯统计学家会说:“等一下,我们还需要考虑一下我们对于这枚硬币的先验知识。”这枚硬币是从附近的杂货店买的,还是从一个名声不怎么样的赌徒那儿得来的?如果这只是一枚普通的硬币,那么大多数人是不会因为9次结果为正面朝上的巧合就发生动摇的。相反,如果我们可以合理怀疑这枚硬币被做了手脚,那我们会更愿意得出这一结论,即9次正面朝上的结果充分证明了偏倚的存在。

贝叶斯统计为我们提供了一种将观察到的证据与我们已有的相关知识(或主观判断)结合起来以获得修正后的判断的客观方法,借由这种方法,我们就可以对下一次硬币抛掷结果的预测进行修正。而频率派无法忍受的正是贝叶斯学派允许观念以主观概率的形式“入侵”“纯洁”的统计学王国的做法。在贝叶斯分析被证明是一种优秀的工具,且适用于各种应用场景,包括天气预报和追踪敌方潜艇之后,主流的统计学家也只能勉强地承认对手的成功。此外,许多例子已经证明,随着数据量的增加,先验判断的影响会越来越小,乃至彻底消失,这就让我们最终得到的那个结论仍然是客观的。

遗憾的是,主流统计学界对贝叶斯学派的主观性的接受并没能促进其对因果主观性的接受。答案在于表述语言上的巨大障碍。为了阐明主观假设,贝叶斯统计学家沿用了高尔顿和皮尔逊的“母语”——概率语言。而阐述因果推断的假设需要的是一种内涵更丰富的语言(如因果图)。

此外,即使数据量增加,因果信息中的主观成分也不一定会随着时间的推移而减少。绘制出两个不同的因果图的两个人可以分析相同的数据,但很可能永远不会得出相同的结论,无论数据有多“大”。这对于科学客观性的倡导者来说是一个可怕的前景,也说明了他们拒绝依赖主观因果信息的确有其必然性。

从积极的一面说,因果推断在一个极其重要的意义上是客观的:一旦两个人就假设达成了一致,因果推断就为他们提供了一种百分之百客观的方法用以解释任何新出现的证据(或数据)。

3. 从证据到因

——当贝叶斯牧师遇见福尔摩斯先生

福尔摩斯所做的并非只是从假设推出结论的演绎,他的拿手本领是归纳。与演绎正好相反,归纳是从证据推出假设。

近年来,人工智能专家在从证据到假设以及从结果到原因的自动化推理方面取得了相当大的进展。我有幸借助开发了实现该功能所必需的一项基本工具(贝叶斯网络)参与了这一发展进程的最初阶段。在本章中,我将简略地对贝叶斯网络做一下介绍,考察当前该工具的一些应用实例,并向大家讲述我在最终进入因果关系研究领域之前所走过的曲折道路。

如果你有一部手机,那么从成千上万个电话中筛选出打给你的电话就是通过信念传播算法(belief propagation)来解码的,而信念传播是专为贝叶斯网络设计的一种算法。作为“互联网之父”之一的温顿·瑟夫曾说:“我们所有人都是贝叶斯方法的超级用户。

:star: 贝叶斯网络与因果图之间的关系很简单:因果图就是一个贝叶斯网络,其中每个箭头都表示一个直接的因果关系,或者至少表明了存在某个因果关系的可能性。反过来,并非所有的贝叶斯网络都是因果关系网络,而在很多实际应用中这一点并不重要。但是,一旦你想问关于贝叶斯网络的第二层级或第三层级的问题,你就必须认真对待因果论,一丝不苟地画出因果图。

贝叶斯留给后世的资料很少,他生前发表过的两篇文章都与概率论无关,但他的遗作《论有关机遇问题的求解》(1763)给他带来了无尽的荣耀。在这篇论文中,他推导出了逆概率公式,即著名的贝叶斯法则。很难评述贝叶斯本人对概率的哲学认识,他的学说被后继者们赋予了更广泛、更深刻的内涵,以致发展成为贝叶斯学派,甚至贝叶斯主义。

频率派和贝叶斯学派对贝叶斯法则的理解是不同的,因而两派借助它来进行推断的手法也不相同。贝叶斯法则是贝叶斯推断的核心,拉普拉斯称之为“最基本原理”

对于贝叶斯来说,休谟的观点很自然地引发了一个问题,有人可能会称其为福尔摩斯式的问题:需要多少证据才能让我们相信,我们原本认为不可能发生的事情真的发生了?在何种情况下,某个假设才会越过绝不可能的界限抵达不大可能,甚至变为可能或确凿无疑呢?虽然这个问题是用概率语言表述的,其含义却带有明显的神学色彩。

贝叶斯法则它表明了我们可以从一个果推断某个因的概率。如果我们知道因,那我们很容易就能估计出果的概率,这是一个前向概率(forward probability)。而它的反面,也就是贝叶斯时代的“逆概率”推理,则难度要大得多。贝叶斯没有解释为什么它很困难,他认为这一点不言而喻,但他向我们证明了逆概率推理是可行的,并展示了如何操作。

这也许是贝叶斯法则在统计学中最重要的应用:我们可以在我们的判断较为可靠的一个方向上直接估算出条件概率,并利用数学工具推导出在我们的判断较为模糊的另一方向上的条件概率。在贝叶斯网络中,该方程也扮演了同样的角色:我们告诉计算机前向概率,在需要时,计算机告诉我们逆概率。

我们还可以将贝叶斯法则看作一种方法,用以更新我们对某一特定假设的信念。理解这一点非常重要,因为人类对未来事件的信念大多取决于该事件或类似事件在过去发生的频率。

两条异议

两条深刻的异议的存在,一条是哲学层面的,另一条是应用层面的。

哲学层面的异议聚焦于将概率解释为一种信念度(degree of belief)的观点,这一哲学争论的关键在于,我们是否可以合法地将“假设我知道”这句表达翻译成概率语言。

贝叶斯学派认为,随机事件(或不确定性事件)A的概率仅是个体主观认为A会发生的信念度。例如,我认为“爱因斯坦在1945年8月6日早上掷过骰子”的概率是90%,而显然没有可重复的随机试验能证实此事,它仅仅表达了我对这个陈述的相信程度。

以符号P(S)作为表示法的概率语言,其根本目的是捕捉概率游戏中的“频率”这一概念。但“假设我知道”是一种认识论范畴的表达,受到知识的逻辑而非频率和比例的逻辑的约束。

在形式上,贝叶斯法则只是贝叶斯给出的条件概率定义的一个初等推论。但在认识论上,它远远超出了初等概念的范畴。事实上,它作为一种规范性规则,能够应用于根据证据更新信念这一重要操作。【哲学起来了。。】其忠实地表达了“假设我知道”这句短语。这句话断定,人们在观察到T之后对S的信念度,永远不会低于人们在观察到T之前对“S且T”的信念度。

应用层面的异议

贝叶斯法则需要先验概率,这取决于不同个体的过往经验,因人而异。

这种变异性也被称为“主观性”,有时被看作贝叶斯推理的一个缺陷。

但也有一些人认为这是贝叶斯推理的一个强大优势,它允许我们在数学上表达我们的个人经验,并以条理化的、易懂的方式将其与数据结合起来。在普通的直觉不起作用或情绪可能导致我们误入歧途的情况下,贝叶斯法则能引导我们进行正确的推理。我们之后将在一些大家熟悉的场景中展示这种力量。

为了明确表述这一问题,我们假设疾病是乳腺癌,你所做的专项体检是乳房X光检测。在这个例子中,前向概率指的是,假设你的确患有乳腺癌,检测结果为阳性的概率:P(检测|疾病)。逆概率指的是:假定检测结果为阳性,检测者确实得了乳腺癌的概率有多大?也就是P(疾病|检测),它表示的是非因果方向的信息流动,根据检测结果推断疾病的概率。

现在,一位40岁的女性做了乳房X光检查以检测乳腺癌,其得到的检测结果为阳性。假设D(代表“疾病”)指她得了癌症,证据T(代表“检测”)指乳房X光检查的结果。那么,她应该在多大程度上相信这个假设?她应该做手术吗?

$(D的更新概率)=P(D|T)=(似然比)×(D的先验概率)$

新术语“似然比”(likelihood ratio)由$P(T|D)/P(T)$给定。它衡量的是,该疾病的患者得到阳性检测结果的概率比一般群体要高多少。因此,方程3.2告诉我们的就是,不管先验概率是多少,新证据T都会通过一个固定的比率增加D的概率。

我们对这一结果(见书)的惊讶源于对前向概率和逆概率的认知偏差,即认为前者的得出经过了深入研究,支持资料翔实,而后者的得出则多涉及个人的主观决策。

前向概率涉及的是疾病本身的性质、发展阶段或检测仪器的灵敏度,其对患病原因(如流行病、饮食、卫生、社会经济地位、家庭史)是不敏感的。逆概率P(疾病|检测)则对这些因素非常敏感。

例子挺不错的,第三章中间。

从许多层面来说,贝叶斯法则都是对科学方法的提炼。教科书对科学方法的描述是这样的:(1)提出一个假设,(2)推断假设的可检验结果,(3)进行实验并收集证据,(4)更新对假设的信念。通常,教科书涉及的只是简单的正确和错误两种结果的检测和更新,证据要么证实了假设,要么驳斥了假设。但是生活和科学从来不会那么简单!所有的证据都包含一定程度的不确定性。贝叶斯法则告诉我们的正是如何在现实世界中执行步骤(4)。

从贝叶斯法则到贝叶斯网络

人工智能的主导机制就一直是所谓的基于规则的系统或专家系统,它将人类知识组织为具体事实和一般事实的集合,并通过推理规则来连接两者。例如:苏格拉底是一个人(具体事实)。所有人都会死(一般事实)。从这个知识库中,我们(或一台智能机器)可以使用普遍推理规则推断出苏格拉底会死的事实,也就是:如果所有A都是B,x是A,那么x也是B。

到了1980年,专家系统显然被证明难以从不确定的知识中做出正确的推断。计算机无法复制人类专家的推理过程,因为专家本身无法使用系统所使用的语言阐明他们的思维过程。

20世纪70年代末,人工智能领域针对如何处理不确定性因素展开了激烈讨论,各种主张层出不穷。

遗憾的是,这些方法虽然具有独创性,却有一个共同的缺陷:它们模拟的是专家,而不是现实世界

在1982年,当时我提出了一个表面上平淡无奇但实际上非常激进的建议:将概率视作常识的“守护者”,聚焦于修复其在计算方面的缺陷,而不是从头开始创造一个新的不确定性理论。更具体地说,我们不能再像以前那样用一张巨大的表格来表示概率,而是要用一个松散耦合的变量网络来表示概率。假设我们只让每个变量与它的几个相邻变量发生相互作用,那么我们就可以克服导致其他概率论者犯错的计算障碍。

作者更确信了这一点,即任何人工智能都必须建立在模拟我们所知道的人类神经信息处理过程的基础上,并且不确定性下的机器推理必须借助类似的信息传递的体系结构来构建。信息是一个方向上的条件概率和另一个方向上的似然比。

网络应该是分层的,箭头从更高层级的神经元指向较低层级的神经元,或者从“父节点”指向“子节点”。每个节点都会向其所有的相邻节点(包括层次结构中的上级节点和下级节点)发送信息,告知当前它对所跟踪变量的信念度(例如,“我有2/3的把握认为这个字母是R”)。接收信息的节点会根据信息传递的方向,以两种不同的方式处理信息。

如果信息是从父节点传递到子节点的,则子节点将使用条件概率更新它的信念,如同我们在茶室例子中见到的那样。如果信息是从子节点传递到父节点的,则父节点将通过用自己的初始信念乘以一个似然比的计算得到更新信念,如乳房X光检查的例子所示。

将这两条规则反复应用于网络中的每个节点的做法就被称为信念传播。

贝叶斯网络

更具普遍意义的说法是:假设→证据。不同于贯穿于本书的因果图,贝叶斯网络并未假设箭头有任何因果意义,这里的箭头仅仅意味着我们知道前向概率,贝叶斯法则告诉我们的是如何逆转正向推理的过程,具体做法就是用先验概率乘以似然比。

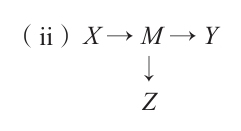

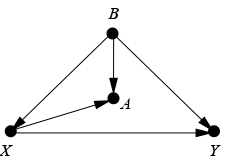

在介绍完只包含一个连接的两节点网络后,我们的下一步自然是引入包含两个连接的三节点网络,我称此种网络为“接合”(junction)。这是所有贝叶斯网络(以及因果网络)的构建模块。接合有三种基本类型或形式,借助这些基本形式,我们就可以在网络中表征出所有的箭头模式。

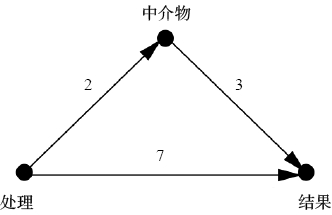

1.A→B→C被称为“链”接合或中介接合。人们常常将B视为某种机制,或“中介物”,它将A的效应传递给C。关于链接合的一个重要概念点:中介物B“屏蔽”(screen off)了从A到C的信息或从C到A的信息,若已知B的值,我们就可以说A和C是条件独立的

例如,一旦我们知道了烟雾的“值”,关于火的任何新信息便不会再以任何理由让我们增强或削弱对警报的信念。

条件独立性赋予了机器关注相关信息而忽略其他信息的自由。在日常思考中,我们每个人都需要这种许可,否则我们会把很多时间花在寻找虚假的信号之上。但是,当每条新信息的出现都在改变着相关信息和无关信息的界限时,我们要如何决定忽略哪些信息呢?对人类来说,这种筛选的能力是与生俱来的,即使是刚刚三岁,还在蹒跚学步的幼童也能理解这种屏蔽效应,尽管他们叫不出它的名字。我相信,他们的本能一定来自某种心理表征,这种表征的形式很可能类似于因果图。但是机器没有这种本能,这也是我们必须给它们配备因果图的一个原因。

2.A←B→C。这种接合形式被称为“叉”接合,B通常被视作A和C的共因(common cause)或混杂因子(confounder)。混杂因子会使A和C在统计学上发生关联,即使它们之间并没有直接的因果关系。给定B之后,A和C就是条件独立的。

3.A→B←C。被称作“对撞”(collider)接合。当我们以中间的变量B为条件时,这种对撞接合的运作方式与链接合或叉接合正好相反。如果A和C原本是相互独立的,那么给定B将使它们彼此相关。这种负相关有时被称为对撞偏倚或“辩解”效应(explain-away effect)

例如,如果我们只选取著名演员的数据(换言之,我们现在只观察“名人=1”的数据),那么我们就会看到才华与美貌之间出现了负相关,这种负相关可以解释为:发现某位名人并不美貌这一事实,会使我们更相信他富有才华。

我刚才提到的条件独立性是在我们孤立地看这些接合时才展现出来的。如果另有因果路径包围它们,那么我们就需要把这些路径也考虑在内。贝叶斯网络所创造的奇迹就在于,理解了我们现在分别介绍的这三种基本接合就足以让我们读取贝叶斯网络所蕴含的所有独立性,不管这个网络有多复杂。

这是从第一层级到第二层级的窥探,而完全登上第二层级的钥匙是d-separation,在第七章。

条件概率表

图示以定性的方式描述了变量间的关系,但如果你想要定量的答案,你就需要定量的输入。在贝叶斯网络中,我们必须具体给出在给定了“父节点”的条件下每个节点的条件概率。这类概率就是前向概率,P(证据|假设)

我们将A描述为根节点,并不是说A的发生不存在起因。实际上,几乎没有任何变量符合这种描述。我们真正的意思是,A的任何先验的因都可以被适当地概括为先验概率P(A),其中A为真。

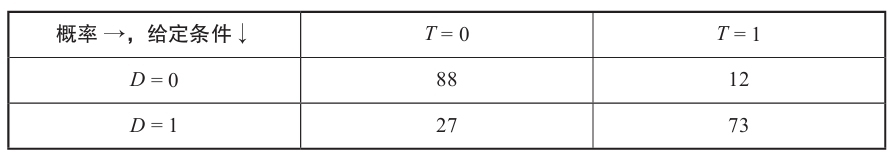

当节点A有父节点时,在决定其自身状态之前,A必须先“听从于”其父节点,一个简单的条件概率表👇

飞机和行李箱。

由于当父节点和父节点状态过多时,表会变得相当大,人们通常会对网络中的连接进行筛选,只保留那些最重要的连接,让网络保持一个相对“稀疏”的状态。在贝叶斯网络的发展过程中,其中一项技术成果就是开发出了一种方法让我们可以利用网络结构的稀疏性实现合理的计算时间。

贝叶斯网络有诸多优势。网络一经建立,调查员就不再需要对其进行干预,告诉它该如何评估新的数据片段。整个网络的升级更新可以很快完成。(贝叶斯网络尤其适合在分布式计算机上汇编和运行。)这个网络是一体化的,这意味着它作为一个整体对所有的新信息做出反应。

贝叶斯网络的透明性使它有别于机器学习的其他模型,后者多倾向于制造高深莫测的“黑箱”。在贝叶斯网络中,你可以一个节点接一个节点地追踪,了解每一个新的证据是如何以及为何改变了整个网络中各个连接的信念的。

2G手机使用的是“软解码”(概率),而不是信念传播。3G手机使用的是贝鲁的turbo码,4G手机使用的是加拉格的类turbo码。贝鲁的绝妙想法是对每条消息进行两次编码,一次是直接编码,另一次是在对信息进行加扰之后编码。如此,我们就得到了两个分开的码字,并且让接收方也接收到了两条带噪音的信息。

没有已知的公式可以直接解码这种双重信息,但贝鲁通过实验证明,如果你在这一贝叶斯网络上重复应用信念传播公式,两件特别神奇的事情就会发生:多数时间(我的意思是99.999%的时间)里,你会得到正确的信息比特。不仅如此,你还可以使用更短的码字。

从贝叶斯网络到因果图

从理论和实践的角度来看,贝叶斯网络抓住了实现因果图与数据的交互的关键。贝叶斯网络的所有概率性质(包括本章前面讨论的接合形式)和在其基础上发展起来的信念传播算法在因果图中仍然有效。事实上,对于理解因果推理,它们不可或缺。

贝叶斯网络和因果图的主要区别在于它们的构造及用途。【从存在和不存在箭头两种情况解释】

实际上,贝叶斯网络只不过是一张巨大的概率表的简洁表示形式。其中的箭头表示子节点的概率通过某个公式(条件概率表)与父节点的值相关联,并且此相关关系是充分的,即发现该子节点还有其他祖先节点不会改变这个公式。

同样,一旦我们知道任意两个节点的父节点的值,那么这两个节点之间缺失的箭头就意味着它们是相互独立的。

然而,如果同样的关系图被绘制成一张因果图,那么绘制因果图的思路和最终我们对图示的解释就会发生改变。在构建阶段,我们需要检查每个变量,比方说C,然后在选择C的值之前弄明白它究竟“听从于”哪些其他变量。在A→B→C链中,B只听从于A,C只听从于B,A不听从于任何变量,即它是由外部力量决定的,这些外部力量不是我们所构建的模型的一部分。

这个听从隐喻浓缩了因果网络所传达的全部知识;其余的知识都可以借此被推导出来,其中在某些情况下我们还需要用到数据。请注意,如果我们反转链接合中箭头的顺序,从而得到A←B←C,那么我们对该结构的因果解读将发生剧烈变化,但其条件独立性则保持不变。A和C之间缺失的箭头仍然意味着,一旦我们知道B的值,A和C就是相互独立的,就像在最初的那个链接合中一样。这一特性具有两个极其重要的含义:

- 首先,因果假设不能是心血来潮的虚构;它们必须经过数据的审查,并且是可证伪的。例如,以B为条件,如果我们观测到的数据并没有表明A和C是独立的,那么我们就可以很有把握地断定链模型与数据不兼容,我们必须放弃(或修复)这一假设。

- 其次,因果图的图形属性决定了哪些因果模型可以借助数据来区分,哪些模型永远无法借助数据来区分,无论数据集有多大。例如,仅靠数据我们不能区分叉接合A←B→C与链接合A→B→C,因为这两种接合的因果图有相同的条件独立性。

:star: 解读因果模型的另一种便捷的方法是假设实验。因果图中的每个箭头可以被看作一个假设实验的结果陈述。

从A到C的箭头表示,如果我们可以只调整A,那么我们理论上就可以看到C的概率发生变化。

从A到C的箭头缺失则表示,在同一个实验中,一旦我们保持C的父节点不变(换言之就是上例中的B),我们在调整A后就不会看到C的任何变化。请注意,“一旦我们知道了B的值”这一概率表达,已经被“一旦我们保持B不变”这一因果表达取代,这意味着我们在这里所做的是在事实上阻止了B的变化,从而使从A到B的箭头失效。

:star: 如果说贝叶斯网络只能告诉我们一个事件发生的可能性有多大,其前提是我们观察到了另一个事件(第一层级的信息),那么因果图就可以回答更高层级的关于干预和反事实的问题。例如,因果叉接合A←B→C就非常明确地告诉了我们,调整A不会对C产生任何影响,无论调整的幅度有多大。与此相对,贝叶斯网络则不具备处理“调整”的能力,也不能辨别“观察到”和“实施调整”的区别,或者明确区分叉接合和链接合。换句话说,链接合和叉接合都能预测我们观察到的A的变化与C的变化有关,但二者都无法预测“调整”A的效果是什么。

第二个意义,也是更为重要的一点,即贝叶斯网络对因果推断的影响。(被揭示出的)因果图的图形结构与它所代表的数据之间的关系,允许我们在不进行实际操作的情况下模拟调整。具体来说,利用一系列巧妙的控制变量操作,我们就可以在没有实际进行实验的情况下预测行动或干预的效果。为了论证这一点,我们可以再想想因果叉接合A←B→C。首先,我们宣称A和C之间的相关是伪相关。我们可以通过一个实验来验证这一论断——调整A,然后发现A和C之间没有相关关系。但我们还可以做得更好。我们可以利用因果图来模拟这个实验,让它告诉我们是否可以通过控制变量操作重现我们在实验中看到的关于相关性的结果。答案是肯定的:在对B进行变量控制之后,在因果图中测得的A和C之间的相关性将等同于我们在实验中得到的相关性结论。这种相关性可以从数据中估计出来,在这个例子中,相关性为零,它如实地确认了我们的直觉,即调整A不会影响到C。

我只知道根据我当初的设想,贝叶斯网络无法回答我提出的问题。意识到自己甚至不能仅依靠数据来区分A←B→C和A→B→C,实在令人感到挫败和痛苦。

我知道读者现在急于弄清因果图是如何让我们能够做出上述计算的,我将在第七章到第九章谈到这部分内容。。。。。

统计学家会在一种特殊的情况下“赦免”因果关系的讨论:随机对照试验(RCT),其中“处理A”被随机地分配给某些个体,而不分配给其他个体,之后我们需要对比在两组个体中观察到的结果变量B的变化的差异。在这里,传统的统计学和因果推断一致认同“A导致B”这句话的含义。

下一章:

我们应该先试着理解旧的、模型盲科学的优势和局限性:为什么我们必须进行随机化处理才能得出A导致B的结论,以及随机对照试验试图消除的威胁(被称为“混杂”)的性质。在我们根据因果图梳理过这些问题之后,我们就可以将随机对照试验置于一个更为适当的理论框架中来讨论了。我们可以将其视为因果推断引擎的一个特例,也可以将因果推断视为随机对照试验的一个宽泛的扩展。

4. 混杂和去混杂

——或者,消灭潜伏变量

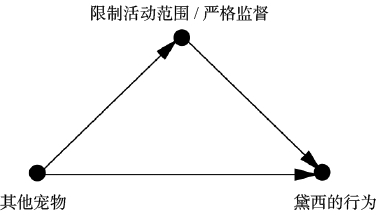

当一个变量同时影响到选择接受处理的对象以及试验结果时,**混杂偏倚(confounding bias)**就产生了。有时混杂因子是已知的,另一些时候它们只是疑似存在,在分析中以“潜伏的第三变量”出现。在因果图中,混杂因子非常容易识别。

如果我们确实测量了第三变量的数据,那么我们很容易就能区分出真实效果和虚假效果。例如,如果混杂因子Z是年龄,而我们分别比较每个年龄组的处理组(treatment group)和对照组(control group)。根据各个年龄组在目标总体中所占的百分比对每个年龄组进行加权,我们就可以计算出药物的平均效果。这种补偿方法是所有统计学家都很熟悉的一种方法,它被称为“Z调整”或“Z控制”。

统计学家既高估又低估了为可能的混杂因子进行统计调整的重要性。

高估它,是指他们经常对过多的变量进行控制,甚至控制了不该控制的变量。你在各种研究中都能看到它。‘我们控制了……’,然后一张关于被控制的变量的列表就开始了,而且这个列表往往被认为越长越好哈哈哈统计学家对于应该控制和不应该控制哪些变量感到非常困惑,所以默认的做法是控制他们所能测量的一切。当今时代的绝大多数研究都采用了这种做法。这的确是一种可轻松遵循的、便捷的、简单的程序,但它既浪费资源又错误百出。而因果革命的一个关键成果就是终结这种混乱。

统计学家又在很大程度上低估了控制的意义,即他们不愿意谈论因果论,即使他们进行了正确的控制。

作者的观点:如果你在因果图中确定了去混因子(deconfounder)的充分集,收集了它们的数据,并对它们进行了适当的统计调整,那么你就有权说你已经计算出了那个因果效应X→Y

统计学家处理混杂的传统方法则与之截然不同,这些方法大多建基于随机对照试验,这是费舍尔极力主张的观点。这一主张本身完全正确,但费舍尔提出这一主张并不是出于一个完全合理的原因。随机对照试验确实是一项极好的发明——但直到最近,追随费舍尔脚步的几代统计学家仍然无法证明他们从随机对照试验中得到的结果就是他们想要得到的东西。他们缺乏一种语言来说明他们所寻找的东西,也就是X对Y的因果效应。

本章的目标之一就是从因果图的角度来解释,为什么随机对照试验能让我们估计出X→Y的因果效应,同时免除混杂偏倚的影响。

因果图使分析重心从混杂因子向去混因子的转变成为可能。前者引发了问题,后者则解决了问题。这两组因子可能存在部分重叠,但并非必须重叠。如果我们收集到了去混因子充分集的数据,那么即使我们忽略了一部分甚至所有的混杂因子也无关紧要了。

它使我们能够确定应该控制哪些变量,使其成为去混因子。它是一个因果概念,属于因果关系之梯的第二层级。

发明于20世纪90年代的因果图方法已经完全解决了混杂问题。特别是我们很快就会介绍的一种被称为“后门标准”(back-door criterion)的方法,它可以明确识别出因果图中哪些变量是去混因子。如果研究者能够收集到这些变量的数据,那么他就可以对这些变量进行统计调整,从而在不真正实施干预的情况下对干预的结果做出预测。

在某些情况下,即使我们没有去混因子充分集的数据,我们也可以控制混杂。在这些情况下,我们可以使用不同的统计调整公式(不是传统的统计调整公式,因为传统的公式只适用于后门标准)消除混杂。【第七章】

掌握既定结论背后的假设,比试图用随机对照试验来规避这些假设更有价值

而且我们在之后会发现,随机对照试验自身也存在局限性。

随机对照试验为何有效

费舍尔意识到,得到对正确问题的不确定答案比得到对错误问题的高度确定的答案要好得多。如果你向自然精灵提出了一个错误的问题,那么你就永远不会得到你想知道的答案。如果你提出了正确的问题,那么偶尔得到一个错的答案就完全不成问题了。你可以估计出答案的不确定性,因为这种不确定性来自随机化的过程(这一过程是已知的)而不是土壤各个方面的特性(这一点是未知的)。

随机化实际上带来了两个好处。第一,它消除了混杂偏倚(它向大自然提出了正确的问题)。第二,它使研究者能够量化不确定性。而根据史学家斯蒂芬·施蒂格勒的说法,第二个好处正是费舍尔提倡随机化的主要原因。

我们可以用do算子来填补费舍尔想要表达但无从表达的内容。让我们从因果的角度来考察一下随机化是如何让我们向自然精灵提出正确的问题的。

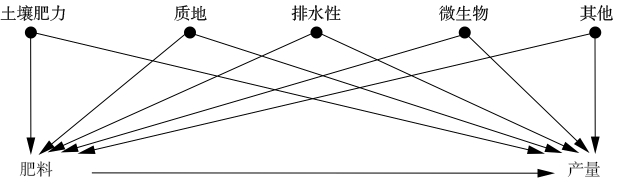

在正常情况下,农民对于每个地块最适合使用哪种肥料是根据心血来潮的想法或偏见来决定的。他想对自然精灵提出的问题是,“对整片土地均匀施撒肥料1(相比于施撒肥料 2)的产量是多少?”或者,用do算子来表示就是,P(产量|do(肥料=1))的值是多少?

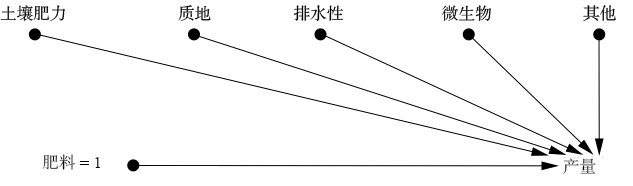

农民想要知道的世界实际上是由模型2描述的👇。do算子在这个例子中的作用是清除所有指向肥料的箭头,并强制赋予这个变量一个特定的值,比如,肥料=1。

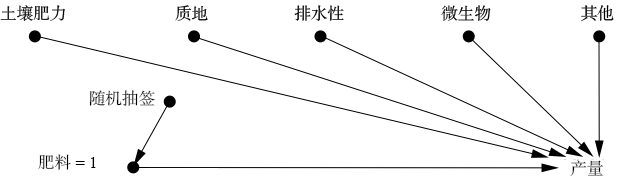

我们让一些地块接受do(肥料=1),让其他地块接受do(肥料=2),但让哪些地块接受哪种处理是随机的。由此模拟出的世界见图4.6,它描述了“肥料”变量从一种随机设备那里获取赋值,比如费舍尔的扑克牌。

图示中没有从随机抽签指向产量的箭头,因为农作物并不能读懂抽签的结果。(对于农作物来说,这是一个相当安全的假设,但对随机化试验中的人类受试者来说,这就是一个应予以严肃考虑的问题了!)【有道理,非常“因果”】对人类受试者进行临床试验时,研究者必须不遗余力地向病人和主试隐瞒处理信息(该试验操作被称为双盲试验)。

模型3描述了这样一个世界,其中肥料和产量之间的关系不存在混杂(换句话说,肥料和产量没有共因)

随机化处理是模拟模型2的一种方法。它让所有旧的混杂因子都失效了,同时并没有引入任何新的混杂因子。

我们还有其他的方式可以用来模拟模型2。如果你知道所有可能存在的混杂因子,那么一种方法就是测量它们并根据它们进行统计调整。不过相比之下,随机化处理确实有一个很大的优势:它切断了接受随机处理的那个变量的所有传入连接,包括我们不知道或无法测量的那些。

很多时候,我们无法满足所有的条件。在某些情况下,干预可能在事实上不可行(例如在研究肥胖对心脏病的影响时,我们不能随机安排病人肥胖与否),或者干预可能是不道德的(例如研究吸烟的影响,我们也不能要求随机选择的一些人抽上10年的烟)。再或者,对于某些较为复杂、参与起来不方便的试验,我们可能会在招募受试者时遇到困难,而勉强找到的志愿参与者又无法代表我们的目标总体。

do算子为我们提供了一种科学的方法,让我们能够在非试验性研究中确定因果效应。这一方法挑战了随机对照试验一直以来的霸主地位。

混杂的新范式

接下来让我们看看因果革命带来的其他消除混杂的方法。

学界对混杂或混杂因子的定义几乎始终未曾达成一致。缺乏对混杂本质的清晰理解

我们观察到的是给定处理效应的条件概率P(Y|X),我们要问自然的问题是X和Y之间的因果关系,该因果关系可以通过干预概率P(Y|do(X))获得。如此一来,混杂就可以简单地定义为:

:star: 导致P(Y|X)≠P(Y|do(X)),即两个概率出现差异的所有因素。

是不是很简单明了?定义困难的原因就在于混杂并非统计学概念。它代表了我们想要评估的内容(因果效应)和我们实际使用统计方法所评估的内容之间的差异。如果你不能在数学上表达出你想评估的内容,那你就无法定义是什么构成了这种差异。

历史上,“混杂”的概念演变围绕着两个相关概念展开——不可比性和潜伏的第三变量。这两个概念都很“抵制”形式化。

当我们谈到可比性时,我们说的是,处理组和对照组应该在所有相关方面都相同,但这就要求我们必须从不相关的属性中区分出相关的属性。

第三变量,混杂因子是X和Y的共因吗?还是仅仅与它们每个都相关?

“混杂的经典流行病学定义”,它包含两个条件。X(处理)和Y(结果)的一个混杂因子Z,满足(1)在整个总体上与X相关,(2)在未接受处理X的人群中与Y相关。近年来,该定义又增加了第三个条件:(3)Z不应当出现在X和Y之间的因果路径上。

混杂因子的“经典流行病学定义”还有其他缺陷,如以下两个例子所示:

(i)X→Z→Y

例(i)中,Z满足条件(1)和(2),但它不是一个混杂因子,而应该被称为“中介物”(mediator)。它是解释X对Y的因果效应的变量。如果你试图找出X对Y的因果效应,那么控制Z将带来一场灾难。

例(ii)中,Z是中介物M的替代物。当实际的因果变量无法测量时,统计学家通常会选择控制其替代物。控制Z本身仍然是一个错误,虽然它带来的偏倚可能会小于控制M,但偏倚仍然存在。

还有一些其他work

do算子和后门标准

信息传递是双向的,既在因果方向传递,也在非因果方向传递。非因果路径恰恰是混杂的根源。

大家应该还记得我将混杂定义为任何使P(Y|do(X))不同于P(Y|X)的因素。do算子会清除指向X的所有箭头,这样它就可以防止有关X的任何信息在非因果方向流动。随机化处理具有相同的效果。如果我们选择合适的变量进行统计调整,那么这种统计调整也具有相同的效果。

(a)在链接合A→B→C中,控制B可防止有关A的信息流向C或有关C的信息流向A。

(b)同样,在叉接合或混杂接合A←B→C中,控制B可以防止有关A的信息流向C,或有关C的信息流向A。

(c)最后,在对撞接合A→B←C中,信息流通规则与前两种是完全相反的。变量A和C原本是独立的,所以关于A的信息不能告诉你任何关于C的信息。但是,如果你控制了B,由于辩解效应的存在,信息就会开始在“管道”中流通。

(d)控制一个变量的后代节点(或替代物)就如同“部分地”控制变量本身。控制一个中介物的某个后代节点意味着部分地关闭了信息管道;控制一个对撞变量的某个后代节点则意味着部分地打开了信息管道。

如果我们有更长的管道和更多的接合单元,就像这样:

A←B←C→D←E→F→G←H→I→J我们有许多方式来阻断A和J之间的交流:控制B,控制C,不控制D(因为它是一个对撞变量),控制E,等等,并且我们只需要做到其中的任何一项就足够了。这就是为什么常规统计过程——控制我们可以测量的一切,造成了如此严重的误导。对这条路径来说,在我们不去控制任何变量的前提下,该路径本身就是被阻断的!

为了去除X和Y中的混杂,我们只需要阻断它们之间的每个非因果路径,而不去阻断或干扰所有的因果路径就可以了。更确切地说,我们将后门路径(back-door path)定义为所有X和Y之间以指向X的箭头为开始的路径;

如果我们阻断了所有的后门路径(因为这些路径允许X和Y之间的伪相关信息在管道中流通),则我们就完成了对X和Y的去混杂。如果我们试图通过控制某一组变量Z来实现这一点,那么我们还需要确保Z的任何成员都不是X的后代,否则我们就可能部分或完全地关闭这条X与Y之间的因果路径。

该图示中存在一个从X到Y的后门路径,X←B→Y,只能通过控制B来阻断。如果B无法被观测,那么不进行随机对照试验的话,我们就无法估计X对Y的因果效应。

在这种情况下,一些(事实上是大多数)统计学家会选择控制A,将其作为不可观测的变量B的替代物,但这种做法只能部分消除混杂偏倚,并引入新的对撞偏倚。

这个游戏引入了一种新的偏倚,名叫“M偏倚”(以图的形状命名)。仅仅因为某个变量(指此处的B)与X和Y都相关就将变量(如B)视为混杂因子是错误的。要重申的是,如果我们不控制B,则X和Y就是未被混杂影响的。只有当你控制了B时,B才会变成混杂因子!

以游戏4的因果图为例,安全带的使用(B)对吸烟(X)或肺部疾病(Y)没有因果影响,它仅仅反映了一个人对于社会规范的态度(A)与对于安全和健康相关措施的态度(C),而其中一些态度可能会影响此人对于肺部疾病的易感性(Y),另一些态度则可能影响人们是否选择吸烟(X)。在实际数据中,人们发现安全带的使用(B)与X和Y相关。事实上,在2006年一项关于烟草诉讼的研究中,安全带的使用甚至被列为需要控制的首要变量之一。而如果你接受了我在游戏4中给出的模型,那么你就能意识到单独控制B是错的。

在掌握了这些新工具,理解了这些新见解之后,科学界终于可以着手处理一些更困难的问题,无论这些问题是理论上的还是实践中的。我们在后续章节会注重介绍这些内容。

5. 消除迷雾,澄清事实

20世纪50年代末60年代初,统计学家和医生就整个20世纪最引人注目的一个医学问题产生了意见冲突:吸烟会导致肺癌吗?

医学史上的很多里程碑式的发展成果都与特定病原体的识别有关。18世纪中叶,詹姆斯·林德发现柑橘类水果可以预防坏血病。19世纪中叶,约翰·斯诺发现被粪便污染的水导致了霍乱。(后来的研究发现了二者更具体的病因:缺乏维生素C会导致坏血病,霍乱杆菌会引起霍乱。)这些杰出的发现都蕴含着一个幸运的巧合——其原因与结果恰巧是一对一的关系。

吸烟与癌症之关系的辩论挑战了这种单一的因果关系概念。许多人吸了一辈子的烟,却从未患肺癌。相反,有些人从不吸烟却依然患上了肺癌。

多尔和希尔将“病例”(患有疾病的人)与对照组进行了比较,因此这种研究类型现在也被称为“病例—对照研究”(case-control study)。相对于时间序列数据而言,借助这种方法搜集数据显然是一种进步,因为研究人员可以控制包括年龄、性别和所接触的环境污染物等混杂因子。然而,病例—对照设计也存在一些明显的弊端。

首先,它是回顾性的,这意味着我们已知研究对象患有癌症,在此前提下我们要回顾过去找出原因。其次,它的概率逻辑也是反向的,这些数据告诉我们的是癌症患者是吸烟者的概率,而不是吸烟者患癌症的概率。对于那些想知道是否应该吸烟的人,吸烟者患癌症的概率才是他们真正关心的概率。

病例—对照研究承认存在几种可能的偏倚来源。

其中之一被称为“回忆偏倚”。被采访者本人肯定知道他们自己是否患有癌症,而这一事实很可能会影响他们的回忆。

另一个来源是选择偏倚:已入院就医的癌症患者绝不是整个人口总体的代表性样本,甚至不能作为吸烟者总体的代表性样本。

前瞻性研究,向6万名英国医生发放调查问卷,采集关于其吸烟习惯的信息,并对他们进行追踪调查。

“剂量—响应效应”(dose-response effect):如果物质A会导致生物反应B,则通常而言(但不是百分之百),更大剂量的A会导致更强的反应B。

敏感度分析

对我们在导言中描述的由因果推断引擎得出的结论进行了补充。

该分析方法的使用者不是通过假设模型中缺少某些因果关系而进行进一步的推断,而是对这些假设直接提出挑战,并评估在解释所观察到的数据时,新的假设所内含的相关性应该达到怎样的强度,之后对此定量结果进行似然性判断,就像假设在这些因果关系不存在的情况下进行的初步判断那样。

我并不否认,怀疑论在科学领域自有其重要意义。可以说,统计学家的工作就是质疑,他们是科学的良心。但是,合理的怀疑论与不合理的怀疑论是有区别的。

因果模型的好处:它能够调用研究者业已掌握的科学知识来分析新问题。费舍尔的方法实际上是在假设研究者对所要测试的假设没有预先的知识或看法。他们把无知强加给科学家,而这正是吸烟致癌论怀疑者在这场争论中乐于利用的优势。

委员会为编写报告准备了一年多的时间,其中一个需要解决的主要问题就是“导致”这个词的使用。委员会成员不得不舍弃19世纪关于因果关系的明确观念,同时还不得不撇开统计学。

委员会列出了5条这样的标准:一致性(在针对不同目标总体的多项研究中得到了类似的结果),关联强度(包括存在剂量—响应效应:吸烟多与更高的肺癌患病风险相关),关联的特异性(一个特定的病原体应该有一个与之对应的特殊的效果,而非带来一连串的影响),时序关系(果应该跟随因)和连贯性[具有生物学的合理性和与其他类型的证据(如实验室证据和时间序列数据)的一致性]。

后来在该清单的基础上又增加了4条标准。如此,这个包含9条标准的清单就成为此后为人所熟知的“希尔标准”。

实际上希尔本人称它们为“观点”,而不是一种强制要求,并强调在特定情况下,任何一条标准都有可能无法被满足。他写道:“我的9个观点中的任何一项都不能为支持或反对因果假设提供无可争辩的证据,而且也没有任何一项可以构成必要条件。”

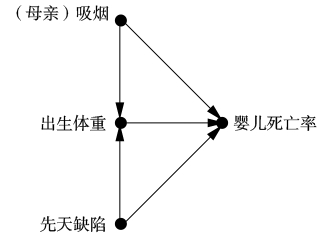

出生体重悖论是对撞偏倚的一个完美的例子。对撞因子是“出生体重”。只观察低出生体重的婴儿,就相当于是在控制对撞因子,从而也就打开了“(母亲)吸烟”和“婴儿死亡率”之间的后门路径,吸烟→出生体重←出生缺陷→婴儿死亡率。这条路径是非因果的,因为其中一个箭头指错了方向。这一路径导致了“吸烟”和“婴儿死亡率”之间的伪相关,造成对于实际(直接)的因果效应,吸烟→婴儿死亡率的估计存在偏倚。事实上,其带来的估计偏倚很大,以致吸烟看起来似乎从有害变成了有益。

科学家因阐明了可能导致不良社会后果的真理而受到道德斥责,类似的事件在历史中屡见不鲜。罗马教廷对伽利略思想的批判无疑是出于对当时社会秩序的真诚的关注和维护。查尔斯·达尔文的进化论和弗朗西斯·高尔顿的优生学也遭受了同样的待遇。然而,此类由新的科学发现带来的文化冲击,最终往往是通过消化了这些发现的文化重组,而不是通过对这些发现的拒斥和掩盖来解决的。

6. 悖论

谁能直面矛盾,谁就能触摸现实。——弗里德里希·迪伦马特(1962)

我们以对出生体重悖论的解决结束了第五章,这一悖论代表了成员众多的一大类悖论,其反映了因果关系和相关关系之间的张力。这种张力源自二者处于因果关系之梯的两个不同的层级之上,又因为人类的直觉在因果逻辑下运作,而数据遵从的是概率和比例的逻辑而进一步加剧。当我们将在一个领域所学到的规则误用到其他的领域时,悖论就出现了。

因果悖论突出强调了直觉性的因果推理模式与概率统计逻辑相冲突的地方。它是一个警示信号,表明如果不用因果透镜看世界,我们很可能会出差错。

1. 蒙提·霍尔悖论

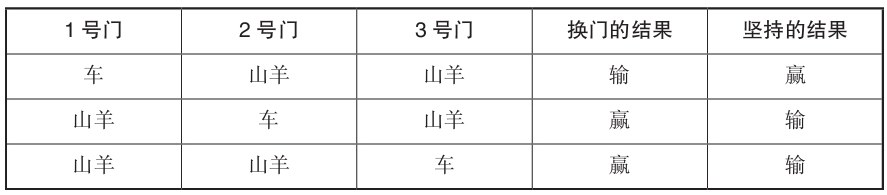

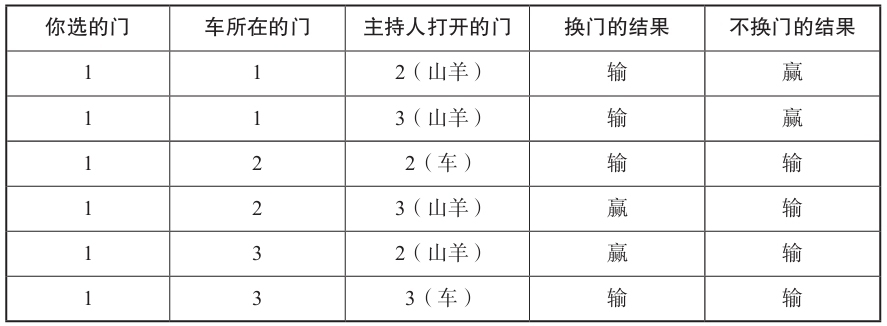

假设你参加了一个竞猜游戏类电视节目,有三扇门供你选择,其中一扇门后面是一辆车(奖品),另外两扇门后面是山羊。

你挑了一扇门,比如说1号门,而主持人知道门后面是什么。现在,他打开了另一扇门,比如说3号门,你看到这扇门的后面是一只山羊。此时,如果他问你:‘你想重新选择,改选2号门吗?’那么,选择换门是否对你赢走奖品更有利?

解决这一悖论的关键是,我们不仅需要考虑数据(主持人打开某个特定门的事实),而且要注意数据生成的过程,也就是游戏规则。

难怪统计学家对这个谜题的答案尤为不解,因为他们已经习惯了“数据约简”(据费舍尔1922年所言)和忽略数据的生成过程。

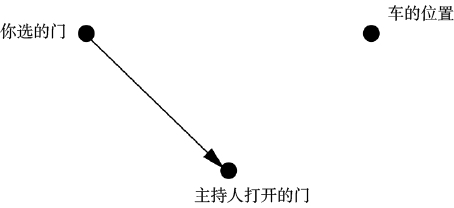

首先,让我们试着略微改变游戏规则,看看会对结论产生什么影响。游戏中蒙提·霍尔同样会打开你没有选择的两扇门之一,但他的选择是完全随机的。换句话说,他可能会打开那扇背后有车的门——真不走运!通过分析我们将会发现,虽然游戏情节看似相同,但根据新的规则,这一次选择换门并不会增加你的胜率。

如果蒙提·霍尔打开了3号门,看到了一只山羊,那么会发生什么呢?首先,这句话告诉了我们一条重要的信息:我们现在位于表格数据部分的第2行或第4行。现在,只关注第2行和第4行,我们可以看到,换门的策略不会再给我们带来任何额外的好处,无论是否换门,我们都只有1/2的获胜概率。

需要注意的是,两个游戏的数据是一样的。我们从这两个例子中得到的教训很简单:获得信息的方式和信息本身一样重要。

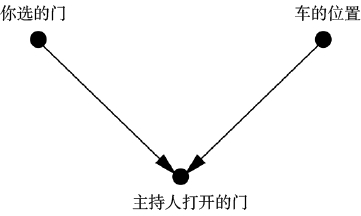

因果图分析

“主持人打开的门”是一个对撞因子。一旦我们获得了关于这个变量的信息,图示中所有的概率就都变成了关于这一信息的条件概率。但是,当我们以对撞因子为条件时,我们就会在两个父节点之间制造出一种虚假的依存关系。这种依存可以体现在根据数据得到的概率中:在主持人打开了3号门的前提下,如果你最初选择了1号门,则车在2号门后面的可能性是其在1号门后面的2倍;如果你最初选择了2号门,则车在1号门后面的可能性是其在2号门后面的2倍。

这无疑是一种匪夷所思的依存关系,我们大多数人都不习惯处理这种类型的依存关系。这是一种没有原因的依存。它纯粹是贝叶斯式的变量控制带来的产物:不涉及因果关系的神奇的信息传递。我们的大脑会自发抵制这种信息传递,因为从幼年起,我们就学会了将相关性和因果关系联系起来。

为什么我说蒙提·霍尔打开3号门是一次“信息传递”呢?你对2号门的信念又是怎么从1/3上升到2/3的呢?答案是,在你选择了1号门之后,蒙提·霍尔就不能再打开它了——他本可以打开2号门,但他没有这样做,而是打开了3号门,这一事实表明他很有可能是不得不这样做的,因为2号门后面可能是汽车。因此,我们就有了比之前更多的证据表明汽车在2号门。

在这张图中,以“打开的门”为条件是一种完全无效操作,因为“你选的门”和“车的位置”原本就是相互独立的

:star: 贝叶斯推理

贝叶斯分析的一个普遍主题:任何通过了威胁其有效性的测试的假设,其可能性都会变得更大。威胁越大,幸存下来的假设的可能性就越大。

在第一个因果图中:2号门很容易被驳斥(蒙提本可以打开它),而1号门则不然。因此,2号门后面更可能是汽车,而1号门后面则更可能不是汽车,汽车在1号门后的概率仍是1/3。

在第二个因果图中:1号门容易被驳斥。因为蒙提·霍尔可以打开3号门并发现门后的汽车,以此证明你选择的门是错的。而因为你最初选择的门和2号门同样容易被驳斥,所以二者背后有车的概率仍然相同。

关于蒙提·霍尔悖论,我实际上给出了两个解释。

第一个解释借助因果推理说明了为什么我们观察到在“你选的门”和“车的位置”之间存在虚假的依存关系,

第二个解释借助贝叶斯推理说明了为什么在“让我们做个交易”中车在2号门背后的概率会增大。

这两种解释都很有价值。贝叶斯解释描述了现象,但并没有真正说明为什么我们在主观上认为它如此矛盾。

在我看来,要想真正解决一个悖论,我们应该首先解释为什么我们会把它看成一个悖论。那么,它究竟揭示了我们对世界的直观看法存在着怎样的重大缺陷呢?【大佬!】

我们的大脑不擅长处理概率问题,但对因果问题则相当在行。而这种因果性的思维方式会导致系统性的概率错误,就像视错觉一样。因为“你选的门”和“车的位置”之间没有因果联系(无论这一因果联系是直接的还是由共因带来的),所以我们对于在数据中发现的概率关联就完全无法理解。

我们的大脑没有准备好去接受无缘无故的相关性,我们需要经过特殊训练,通过分析和学习如蒙提·霍尔悖论或我们在第三章中讨论的例子,才能辨别出这种相关性可能出现的场合。一旦我们完成了“大脑重塑”,能够识别出对撞接合,悖论就不会再令我们感到困惑了。

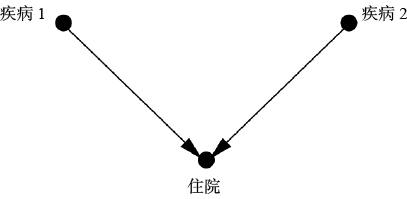

伯克森悖论

1946年,梅奥诊所的生物统计学家约瑟夫·伯克森指出了在医院进行的观察性研究的一个特性:两种疾病即使在一般人群中彼此不存在实际联系,在医院的病人中也会形成某种似是而非的关联。

不妨先设想一种非常极端的可能情况:无论是疾病1还是疾病2都没有严重到足以让患者必须住院的地步,但两者的结合会导致患者必须住院。在这种情况下,我们的预测是在住院病人这个总体中疾病1与疾病2高度相关。

在此前提下,在针对住院病人进行研究时,我们就相当于控制了“住院”这个因子。正如我们所知,以对撞因子为条件这一操作制造了“疾病1”和“疾病2”之间的伪相关。在我们以往提到的许多例子中,因为辩解效应的存在,这种伪相关多呈负相关,但在这个例子中,这种伪相关是正向的,因为患者住院的前提就是同时患有两种疾病。

今天的流行病学研究者已经理解了因果图以及其中包含的偏倚。关于该问题的讨论焦点已经转移到技术方面的细节,即偏倚可以是多大,以及它是否大到可以在包含更多变量的因果图中被观察到。这就是进步!

我们大脑思考机制的缺陷。我们在实际生活中似乎就是遵循着共因原则行事的,无论何时,只要观察到某种模式,我们就会去寻找一个因果解释。事实上,我们本能地渴望根据数据之外的某个稳定机制对观察结果做出解释。

在最纯粹、最本质的意义上,我们观察到的相关就是一种错觉,甚至可能是一种自欺欺人:我们选择哪些事件进入数据集同时忽略另一些事件的做法给我们自己带来了错觉。重要的是要认识到,我们并非总能意识到自己做出了这个选择,这就是为什么对撞偏倚总是能轻易欺骗那些粗心的人。

对撞的扭曲棱镜在日常生活中同样普遍存在。正如乔丹·埃伦伯格在《魔鬼数学》(How Not to Be Wrong)中提出的问题:你有没有注意到,在你约会的人当中,那些有魅力的人往往是混蛋?可悲的事实是,没有魅力的人可能会和有魅力的人一样刻薄,但你永远意识不到这一点了,因为你永远不会约会既刻薄又没有魅力的人。

辛普森悖论

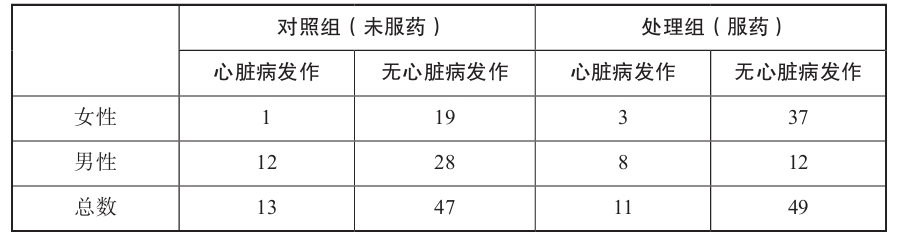

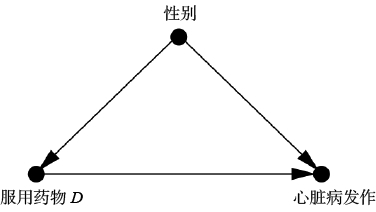

假设有一名医生,我们称其为辛普森医生,他在办公室阅读文献时发现了一种很有前途的新药(药物D),这种新药似乎可以降低心脏病发作的风险。于是,他兴奋地在网上查找起了研究人员公布的实验数据。当他看到男性患者的数据时,他注意到如果这些患者服用了药物D,则他们的心脏病发作风险反而变得更高了。他的兴奋程度因此略有下降。“哦,好吧,”他想,“这样的话,药物D一定对女性非常有效。”

让我再次强调一下悖论之所在。如你所见,在女性患者中,对照组中有5%(1/20)的患者后来心脏病发作,而服用该药的患者中有7.5%的人后来心脏病发作。因此我们认为,这种药物与女性患者中较高的心脏病发作风险有关。在男性患者中,对照组中有30%的患者后来心脏病发作,而处理组中有40%的患者后来心脏病发作。因此我们认为,这种药物与男性患者中较高的心脏病发作风险有关。辛普森医生是对的。

但现在让我们看看表6.4的最后一行。在对照组中,有22%的人后来心脏病发作,但处理组中的这一比例仅为18%。因此,如果我们仅根据最后一行判断,则药物D似乎的确降低了整个患者群体的心脏病发作风险——欢迎来到辛普森悖论的离奇世界!

任何声称能够解决悖论(特别是那些经过几十年仍未得到解决的悖论)的方法都应该符合一些基本标准。第一,正如我上面讨论蒙提·霍尔悖论时说的那样,它应该能够解释为什么悖论会令人困惑或让人拒绝相信。第二,它应该能够确定悖论可能出现的场景类别。第三,它应该能够告诉我们,在哪些情况下悖论不可能发生(如果确实存在这种情况的话)。第四,当悖论真的发生,而我们必须在两个看似合理但矛盾的陈述中做出选择时,它应该能够告诉我们哪个说法是正确的。

让我们从辛普森悖论为何会令人困惑这一问题开始。为了解释这一点,我们必须先区分两个概念:辛普森逆转和辛普森悖论。

辛普森逆转是一个纯粹的数字事实:在合并样本时,两个或多个不同的样本关于某一特定事件的相对频率出现反转。

很多人似乎相信,如果$A/B>a/b$且$C/D>c/d$,那么$(A+C)/(B+D)>(a+c)/(b+d)$就是自然成立的。但这种民间智慧是完全错误的。

现在让我们回到那个最重要的例子,BBG药物悖论。当“对男性有害”“对女性有害”“对人类有益”这三个陈述被理解为比例增减时,它们在数学上并不矛盾,然而,你可能仍然认为这种情况在现实世界中不可能出现,因为一种药物不可能既导致心脏病发作又防止心脏病发作。BBG药物确实不存在,也永远不可能被发明出来,我们可以在数学上证明这一结论。

“确凿性原则”(sure–thing principle)

假设一位商人正在考虑购买某处房产。他认为下一届总统选举的结果与之有重大关系。因此,为了弄清楚这件事,他问自己,如果他知道民主党候选人将获胜,他是否愿意购买此处房产,他的答案是他会购买。同样,他又问自己,如果他知道共和党候选人将获胜,他是否愿意购买此处房产,他发现他仍然会选择购买。当得知无论竞选结果如何他都会选择购买之后,他便决定这处房产是一定要购买的。但是这有可能发生 辛普森逆转!比如商人的购买决定可以改变选举的结果(比如借助媒体对其行为的曝光)

请注意,确凿性原则中缺失的成分(萨维奇对此未做明确说明)实际上是一个因果假设。该原则的正确版本应当这样表述:假设无论事件C是否发生,某个行动都会增加某一结果的可能性,则该行动也将在 我们不知道C是否发生的情况下 增加这个结果的可能性,条件是该行动不改变C的概率。

根据修正后的确凿性原则,下面三句陈述之一必定为假:药物D增加了男性患者和女性患者的心脏病发作的概率;药物D降低了整个总体的心脏病发作的概率;这种药物不会改变男性和女性的数量。因为药物改变病人性别的事不太可能发生,所以前两句陈述中一定有一句为假。

要回答这个问题,我们必须在数据范围之外探寻数据生成的过程。在这项研究中,女性显然更倾向于服用药物D,而男性则相反。因此,性别就是是否服用药物和心脏病发作的混杂因子。为了客观估计药物对心脏病发作的影响,我们必须对混杂因子进行控制。我们可以通过单独查看男性和女性的数据然后取平均值来做到这一点。

•对女性患者而言,未服用药物D者心脏病发作的概率为5%,服用药物D者心脏病发作的概率是7.5%。

•对男性患者而言,未服用药物D者心脏病发作的概率是30%,服用药物D者心脏病发作的概率是40%。

•取算术平均值(因为男性和女性在一般总体中比例接近1∶1),未服用药物D者心脏病发作的概率为17.5%(5和30的平均值),服用药物D者心脏病发作的概率为23.75%(7.5和40的平均值)。

这就是我们所寻找的对于这个问题的清晰、明确的答案。药物D不是BBG药物,它是BBB药物:对女性、男性有害,对人类有害。

辛普森悖论提醒我们,在某些情况下,至少存在一个统计趋势(无论是来自聚合数据、分层数据还是同时来自两者)无法代表真正的因果效应。例如,根据聚合数据估计出的因果效应大于根据分层数据估计出的每一层的因果效应,而如果我们恰当地控制了混杂因子,此类误差就不会出现。

逆转也可能发生在包含连续变量的情况中,对此,我们可以绘制相应的图示,以便更好地理解。

只有当每个子总体(每个初始体重级别)的相对比例(男女生比例)在各群组之间一致的情况下,确凿性原则才起作用【上文中用于处理叉连结里的混杂因子B】。然而,在罗德的例子中,“处理”(性别)对每个体重级别里学生的百分比的影响非常大。

(用在上文的例子中,子总体是性别,相对比例并未体现,是其他的量,各群组是指男和女。)

无论哪种情况,因果图都能告诉我们应该使用哪种数据处理程序。

【罗德悖论没完全看懂,保留一些疑惑,等以后再来看】

7. 超越统计调整

——征服干预之峰

在这一章,我们终于勇敢地登上了因果关系之梯的第二层级,干预——自古至今因果思考的圣杯。这一层级所涉及的内容是对未尝试过的行动和策略的效果进行预测。

混杂因子是导致我们混淆“观察”与“干预”的主要障碍。在用“路径阻断”工具和后门标准消除这一障碍后,我们就能精确而系统地绘制出登上干预之峰的路线图。最安全的路线是后门调整和由此衍生的诸多同源路线,它们有些可以归于“前门调整”名下,有些则可以归于“工具变量”名下。

但是这些路线并非在所有情况下都可行,因此对富有经验的登山者来说,我将在本章最后介绍一种通用的绘图工具,我们称之为“do演算”(do–calculus),它允许研究者探索并绘制出通往干预之峰的所有可能的路线。

后门调整

对于许多研究者来说,最常用的(可能也是唯一的)预测干预效果的方法是使用统计调整公式“控制”混杂因子。如果你确信自己已掌握了变量的一个充分集(我们称之为去混因子)的数据可以用来阻断干预和结果之间的所有后门路径,那么你就可以使用此方法。

为了做到这一点,我们首先需要估计去混因子在每个“水平”或数据分层中产生的效应,并据此测算出干预的平均因果效应。

然后,我们需要计算这些层的因果效应的加权平均值,为此我们需要对每个层都按其在总体中的分布频率进行加权。

后门标准在这一过程中所起的作用是,保证去混因子在各层中的因果效应与我们在这一层观察到的趋势相一致。如此一来,我们就可以从数据中逐层估计出因果效应。如果没有后门标准,研究者就无法保证所有的统计调整都是合理的。

在许多情况中,变量X、Y或Z都是数值变量,比如常见的收入、身高以及出生体重等。对于变量可以(或者至少是为了某个实用目的)取无限多个可能的值的情况,我们就不能都罗列出来了。

将数值分成有限并且数目可控的类别。这种处理方式原则上没有错,但我们对分类方式的选择可能存在主观性。不仅如此,如果需要进行统计调整的变量比较多,那么类别的数量就会呈指数增长,这将使计算过程变得难以执行。更糟糕的是,在分类完成后,我们很可能会发现许多层缺乏样本,因此我们无法对其进行任何概率估计。

为应对这种“维度灾难”问题,统计学家设计了一些颇为巧妙的方法,其中大多数都涉及某种数据外推法,即通过一个与数据拟合的光滑函数去填充空的层所形成的“洞”。

运用最为广泛的光滑函数当然是线性近似,这种嵌入带来了一个计算上的优势:每个因果效应都可以用一个数字(路径系数)来表示。线性近似的第二个同样重要的优势是,根据统计调整公式进行计算的过程非常简单。

回归

弗朗西斯·高尔顿发明的回归线,它涉及由大量数据点组成的数据点云以及一条穿过这团数据点云的最佳拟合直线。

方程是:$Y=aX+b$ ,此处的回归系数是a

回归系数(regression coefficient)在回归方程中表示自变量x 对因变量y 影响大小的参数。 回归系数越大表示x 对y 影响越大,正回归系数表示y 随x 增大而增大,负回归系数表示y 随x增大而减小。

如果存在一个混杂因子Z会怎样?在这种情况下,相关系数$r_{YX}$不会告诉我们平均因果效应,它只会告诉我们观察到的平均趋势。对此,我们仍然有一个摆脱困境的方法:将所有这三个变量放在一起绘制趋势图,如此,我们采集到的数据就构成了XYZ空间中的一团点云,在三维空间中,与回归线对应的概念是回归平面,它的方程可以表示为$Y=aX+bZ+c$。我们可以很容易地从数据中计算出a、b、c。此时,一件美妙的事发生了,系数a给出了Y在X上的回归系数,并且这两个变量都已根据Z进行了统计调整。(该系数也被称为偏回归系数,写作$r_{YX.Z}$)

我们可以借助统计工具包很快地算出这个平面。平面方程Y=aX+bZ+c中的系数a将自动根据混杂因子Z调整所观察到的Y对X的趋势。

你也可以轻松地将这一处理过程扩展应用于包含多个变量的问题。如果一组变量Z恰好满足后门标准,那么回归方程中X的系数a就是X对Y的平均因果效应。

好几代研究者开始相信,经过统计调整的回归系数(或偏回归系数)在某种程度上被赋予了因果信息,这正是未经过统计调整的回归系数所缺乏的。

回归系数有时可以体现因果效应,有时则无法体现,而其中的差异无法仅依靠数据来说明。我们还需要具备另外两个条件才能赋予$r_{YX.Z}$以因果合法性。

第一个条件是,我们所绘制的相应的因果图应该能够合理地解释现实情况;

第二个条件是,我们需要据其进行统计调整的变量Z应该满足后门标准。

基于回归的统计调整只适用于线性模型

后门调整公式和后门标准就像硬币的正反面。后门标准告诉我们哪些变量集可以用来去除数据中的混杂。统计调整公式所做的实际上就是去混杂。在线性回归最简单的例子中,偏回归系数在暗中执行了后门调整。在非参数问题中,我们必须公开地根据后门调整公式做出统计调整,要么直接对数据进行统计调整,要么对数据的某个外推版本进行统计调整。

非参数问题是指统计总体分布形式未知或虽已知却不能用有限个参数刻画的统计问题。 在多数场合下,与参数问题界线清楚,只在少数情况下会因为各人出发点不同而有不同看法。 非参数方法有拟合优度检验、次序统计量、U统计量、秩统计量与秩方法、置换检验、非参数回归与判别等等。

后门调整仍然是有效的。只不过在非参数问题中,我们需要使用其他的数据外推法来对付维度灾难。

前门标准

如果我们因缺乏必要的数据而无法阻断某条后门路径,统计调整公式就会完全失灵。

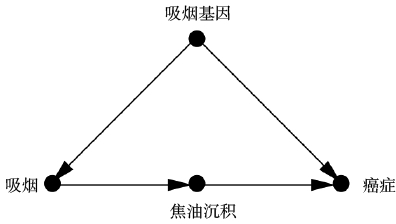

假设逻辑关系如下:

我们收集了每个志愿者关于“吸烟”、“焦油沉积”和“癌症”的数据。遗憾的是,我们无法收集关于“吸烟基因”的数据,因为我们不知道这种基因是否存在。由于缺乏混杂因子的数据,我们不能阻断“吸烟←吸烟基因→癌症”的后门路径。因此,我们不能使用后门调整来控制混杂因子的影响。

前门指的是直接的因果路径“吸烟→焦油沉积→癌症”,而且我们的确已经收集到了全部三个变量的数据。

首先,我们可以估计出“吸烟”对“焦油沉积”的平均因果效应,因为“吸烟”和“癌症”之间没有未被阻断的后门路径,我们甚至不需要对其进行后门调整,因为这条后门路径已经被阻断了。我们只需要观测P(焦油沉积|吸烟)和P(焦油沉积|不吸烟),二者的差别就是吸烟对焦油沉积的平均因果效应。

估计“焦油沉积”对“癌症”的平均因果效应。我们可以通过对“吸烟”进行统计调整来阻断从“焦油沉积”到“癌症”的后门路径:焦油沉积←吸烟←吸烟基因→癌症。我们只需要收集一个去混因子充分集的数据(在此例中就是变量“吸烟”的数据),就可以借助后门调整公式得到P(癌症|do(焦油沉积))和P(癌症|do(无焦油沉积))二者的差别就是“焦油沉积”对“癌症”的平均因果效应。

结合:

癌症的产生有两种不同的情况,其一为“焦油沉积”存在的情况,其二为“焦油沉积”不存在的情况。如果我们强迫一个人吸烟,那么这两种情况的概率就分别是P(焦油沉积|do(吸烟))和P(无焦油沉积|do(吸烟))。如果“焦油沉积”的情况继续发展下去,那么“焦油沉积”导致“癌症”的可能性就是P(癌症|do(焦油沉积))。而如果“无焦油沉积”的情况继续发展下去,那么其导致“癌症”的可能性就是P(癌症|do(无焦油沉积))。我们可以在do(吸烟)这一前提下,根据两种情况发生的概率对其进行加权,这样就能计算出吸烟导致癌症的总概率。如果我们阻止一个人吸烟,即前提条件为do(不吸烟),则相同的论证同样有效。两者之间的差异就表示了相对于不吸烟,吸烟对于癌症的平均因果效应。

在这里,X代表“吸烟”,Y代表“癌症”,Z代表“焦油沉积”,U(在此例中显然没有出现在公式中)代表不可观测的变量,即“吸烟基因”。

$P(Y|do(X))=∑_zP(Z=z,X)∑_xP(Y|X=x,Z=z)P(X=x) (7.1)$

对数学有兴趣的读者可能会发现,将这个公式与后门调整公式进行比较会得到一个很有趣的结果,其中后门调整公式如下所示。

$P(Y|do(X))=∑_zP(Y|X,Z=z)P(Z=z) (7.2)$

你在公式中的任何地方都看不到U(“吸烟基因”)的存在。我们甚至在未采集到任何数据的时候就成功地排除了混杂因子U。

公式的左边代表问题“X对Y的影响是什么”,右边则是被估量,也即回答问题的一种方法。被估量以条件概率的形式表示,其不包含关于实际干预的数据,只包含观测到的数据。这意味着它可以直接根据数据估计出来。

在假设正确的情况下,即使我们没有混杂因子的数据,我们照样可以用数学的方式消除混杂因子的影响。适用于此种处理方式的情况可以很清楚地识别出来——X对Y的因果效应被一组变量(C)混杂,又被另一组变量(M)介导,并且中介变量M不受C的影响。当你看到满足上述条件的问题时,你就知道你可以从观测数据中估计出X对Y的影响。

实际情况中,只要C对M的影响足够微弱,前门调整就可以给出一个相当合理的关于X对Y影响的估计。这个估计比在不控制C的情况下所做的估计要好得多。

前门调整的强大之处:它允许我们控制混杂因子,并且这些混杂因子可以是我们无法观测(如“动机”)甚至无法命名的。前门估计所做的事与随机对照试验大体类似,并且还有一个额外的优点,即它的研究对象可以存在于自然的生活环境而非实验室的人造环境。

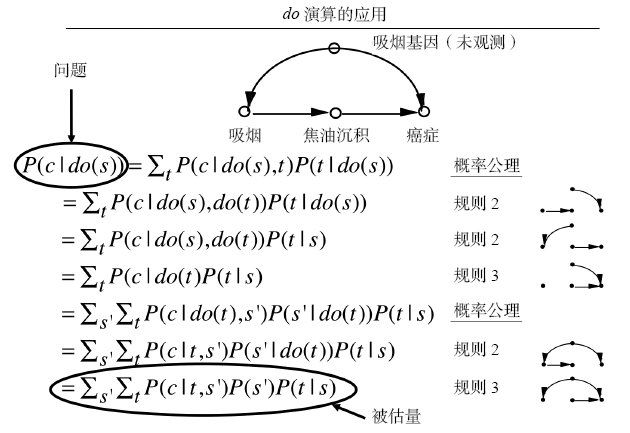

do演算,或者心胜于物

前门调整公式和后门调整公式的最终目标是根据P(Y|X,A,B,Z,…)此类不涉及do算子的数据估算干预的效果,即P(Y|do(X))。如果我们成功消除了计算过程中的do概率,那么我们就可以利用观测数据来估计因果效应,这样一来,我们就从因果关系之梯的第一层级踏上了第二层级。

问题:是否还存在其他的门,通过这些门,我们可以消除所有的do。

从一个更宏观的视角,我们也可以这样问,即是否存在某种方法可以用来事先确定一个给定的因果模型是否适用于这种消除处理。如果存在这种方法,那么我们就可以对适用的因果模型进行此类处理,从而在不进行实际干预的情况下估算出因果效应。而对于不适用的模型,我们至少可以知道,我们在模型中嵌入的假设不足以让我们仅根据观测数据来揭示因果效应,同时对此种情况,我们也将意识到,无论我们有多聪明,要解决这个问题,进行某种干预性试验都是在所难免的。

任何了解随机对照试验的成本和操作难度的研究者显然还是更希望通过纯数学的手段做出这些判断。

回到我们的核心问题,即一个模型何时可以取代一个试验,或者一个“干预”量何时可以简化为一个“观察”量。

我们从目标句P(Y|do(X))开始。如果我们能成功地消除它的do算子,只留下像P(Y|X)或P(Y|X,Z,W)这样的经典条件概率表达式,那么我们的任务就完成了。:star:

- 规则1:如果我们观察到变量W与Y无关(其前提可能是以其他变量Z为条件),那么Y的概率分布就不会随W而改变。

P(Y|do(X),Z,W)=P(Y|do(X),Z)

条件是,在我们删除了指向X的所有箭头后,变量集Z会阻断所有从W到Y的路径。 - 规则2:如果变量集Z阻断了从X到Y的所有后门路径,那么以Z为条件,则do(X)等同于see(X)。

如果Z满足后门标准,这种变换就可以写作:P(Y|do(X),Z)=P(Y|X,Z) - 规则3:如果从X到Y没有因果路径,我们就可以将do(X)从P(Y|do(X))中移除。如果不存在只包含前向箭头的从X到Y的路径,P(Y|do(X))=P(Y)

每条规则都附带一个简单的句法解释。规则1允许增加或删除某个观察结果。规则2允许用观察替换干预,或者反过来。规则3允许删除或添加干预。

然而,我无法确定do演算的这三条规则是否充分。我们是否遗漏了第四条规则,而它可以帮助我们解决这三条规则所不能解决的问题?

我之所以选择这三条规则,是因为它们足以处理我所知道的所有不同类型的情况。

我猜想,只要因果效应可以从数据中估计出来,我们就可以利用这三条规则通过一系列处理步骤消除do算子。但我还没能证明这一论断。

这类问题在数学和逻辑学中有许多先例。我想证明的这种性质在数学逻辑上通常被称为“完备性”。一个完备的公理系统有这样一种特性,即其中的公理足以推导出使用该公理系统的语言书写的任何正确表述。

后来被他的两组学生分别独立证明了。

就像其他运算一样,它可以让某种有效的理论建构得到证明,但它并不能帮助我们找到理论建构本身。它是一个优秀的解决方案验证工具,但并不是一个很好的解决方案搜索工具。

在数理逻辑中,这类问题被称为“决策问题”。许多逻辑系统在构建过程中都经历过棘手的决策问题的阻挠。例如,假设有一堆尺寸不等的多米诺骨牌,我们没有一个简易的方法来确定是否可以将其以某种方式排列,以严丝合缝地填满一个指定大小的正方形。然而,一旦某个排列方法被提出来,我们就能在极短的时间内验证它是否可以构成一个解决方案。

幸运的是(再一次),对do演算来说,这一决策问题已被证明是可解决的。基于我另一个学生田进(音)所做的前期工作,伊利亚·斯皮塞发现了一个算法,该算法可以用于确定某个解决方案是否存在“多项式时间”(polynomial time)。

假设出现了最糟糕的情况,即我们的因果模型不允许我们仅通过观测数据来估计P(Y|do(X))的因果效应,并且我们也不能进行随机分配处理X的随机化试验。

此时,聪明的研究者可能会问,我们是否可以通过随机化其他变量(如Z,因为Z比X更易于控制)来估计P(Y|do(X))?接下来要问的问题就变成了,我们是否能找到这样一个让我们得以回答因果问题的替代变量Z。在do演算的世界中,该问题就等同于,我们是否可以找到一个变量Z,让我们得以将P(Y|do(X))变换为一个新的表达式,其中do算子的限制目标变成了Z,而不再是X。

幸运的是,它也有一个完备的解决方案。

当我们考虑某个实验结论的可移植性或外部有效性(评估在与原始研究环境存在几处关键方面的差异的新环境中,实验结果是否仍然有效)时,更多类似的问题就出现了。此类更具挑战性的问题触及了科学方法论的核心,因为只要是科学就会涉及结论的普遍化。

2015年,巴伦拜姆和我向国家科学院提交了一篇论文,在其中我们给出了这个问题的解决方案,前提是研究者可以用因果图来表示其对这两个环境的假设。在满足此前提的条件下,do演算规则提供了一种系统化的方法,用以确定在研究环境中发现的因果效应是否能帮助我们估计目标环境中的因果效应。

do演算的另一个重要价值在于其透明性

其中对于因果效应的估计需要我们找到一个超越前门调整和后门调整的方法。

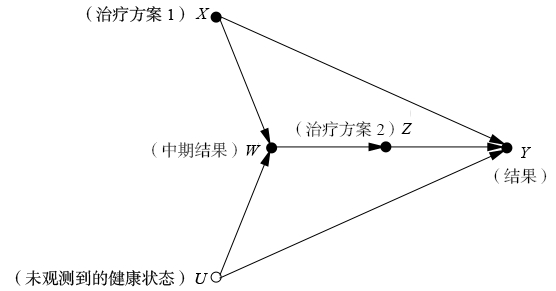

“序贯决策”(sequential decisions)或“时变处理”(time–varying treatments)的问题

以艾滋病治疗为例,通常,艾滋病治疗是在较长的一段时间内进行的,并且在每个治疗阶段,医生都会根据患者的实际情况调整后续治疗的强度和用药剂量。同时,患者的病情也会受到此前治疗方案的影响。

在保持Z恒定不变且独立于观测值W的前提下,预测治疗方案X对结果Y的影响。

我们的目标量是P(Y|do(X),do(Z)),而我们可以采集到的数据以P(Y|do(X),Z,W)和P(W|do(X))为表示形式。

这两个表达式反映了这样一个事实:此研究中的Z并不取决于某个外部因素,而是遵循某种(未知的)机制随W的变化而变化。因此,我们的任务就是将目标表达式变换为另一个表达式,以反映do算子仅适用于X而非Z这一研究条件。如此一来,我们就可以通过简单地运用do演算的三条规则来解决这个问题了。这个故事有效地证明了,能够解决艰深的理论问题的数学工具,在现实中也能发挥作用。

do演算理论系统的构建花费了20多年的时间,其中我的好几位学生和同事都为之做出了自己的贡献。

维尔玛证明了广为人知的d分离性

还需要证明除了通过路径阻断揭示出来的独立性之外,该因果图不隐含其他的独立性。这部分关键的补充性证明是由我的另一位学生丹·盖革完成的。

田进提出的方法后来被称为“c分解”(c–decomposition),正是在此方法的基础之上,伊利亚·斯皮塞后来为do演算开发出了一整套完整的算法系统。

伊利亚去证明do演算的完备性

删除因果图中的箭头这一想法仍然激发了大量的新见解和新成果的出现。后门标准就是这种转换思想的第一个衍生成果,而do演算可以算是第二个。并且,这种转换带来的红利仍然有待挖掘,在反事实、(实验结果)普遍化、数据缺失情况下的结果估计和机器学习等研究领域,无数新成果依然在不断涌现。

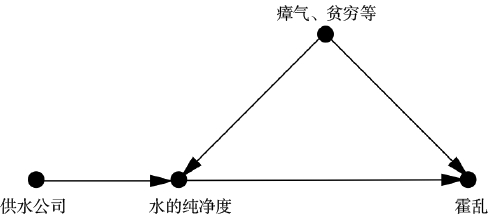

工具变量

新的因果图如图7.8所示。斯诺艰辛的调查工作证实了两个重要的假设:

(1)“霍乱”和“供水公司”之间没有箭头(二者是独立的)

(2)“供水公司”和“水的纯净度”之间有一个箭头。此外,斯诺没有做出明确说明,但同样重要的第三个假设是:

(3)“供水公司”和“霍乱”之间没有直接箭头。这一点在今天是显而易见的,因为我们知道供水公司不可能通过其他的渠道将霍乱病菌输送给客户。

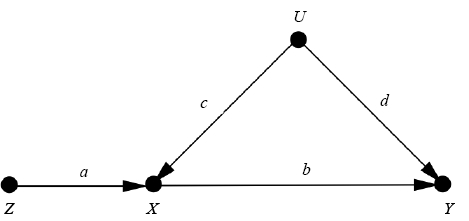

满足这3个属性的变量,在今天被称为工具变量(instrumental variable)【上文中的供水公司和下图中的Z】

这个变量就类似于抛硬币,它模拟的是一个没有箭头指向的变量。由于“供水公司”与“霍乱”的关系中不存在混杂因子,因此任何观察到的二者之间的关联都必然是因果关联。同样,由于“供水公司”对“霍乱”的影响必须通过改变“水的纯净度”生效,由此我们可以得出结论(与斯诺的结论一致),观察到的“水的纯净度”和“霍乱”之间的关系也必然是因果关系。

让我们先解释一下工具变量是如何起作用的。为了简化说明,我们用变量Z、X、Y、U替代具体的变量名称,

路径系数(a,b,c,d),以表示因果效应的强度。这意味着我们假设变量都是数值变量,且变量的相关函数是线性的

由于Z和X之间不存在混杂,因此Z对X的因果效应(a)可以根据$r_{XZ}$估计出来,其中$r_{XZ}$是X在Z上的回归线的斜率。同样,变量Z和Y的关系也未被混杂,因为路径Z→X←U→Y被X处的对撞阻断了。因此Z在Y上的回归线斜率($r_{ZY}$)就等于直接路径Z→X→Y的因果效应,即路径系数的乘积:a*b。因此,我们就有了两个方程:$ab=r_{ZY}$和$a = r_{XZ}$。用第一个方程除以第二个,我们就得到了X对Y的因果效应:$b=r_{ZY}/r_{ZX}$ :star:

通过这些步骤,工具变量就许可了我们执行与前门调整相同的处理:在无法控制混杂因子或收集其数据的情况下估计X对Y的效应。

还请注意,我们所做的是根据因果关系之梯第一层级的信息(相关系数rZY和rZX)推导出第二层级的信息(b)。

之所以能够做到这一点,是因为路径图所体现的假设在本质上是因果关系,尤其是“U和Z之间没有箭头”这个关键假设。

在因果革命之前,人们就已经对工具变量有所了解,但是因果图以一种更清晰的方式表明了它们是如何发挥作用的。

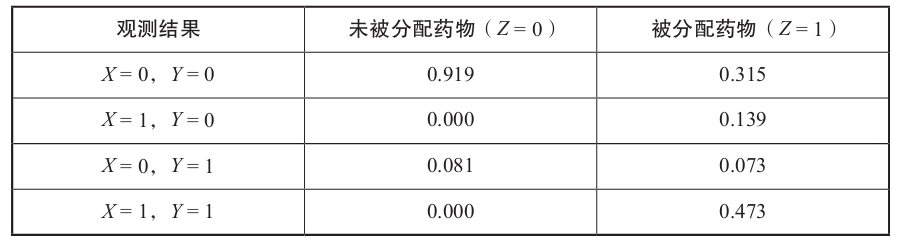

胆固醇的例子,见原文。

变量都是二元变量,因此不能使用线性模型,上文的工具变量公式也无用。在这种情况下,我们通常可以用一种被称为“单调性”(monotonicity)的弱相关来代替线性假设

单调性

同时还要注意表中有两个0:没有人没被分配药物(Z=0)却服用了药物(X=1)。在运行良好的随机化研究中,这种情况一般而言是真实的,特别是在医学领域,通常医生都有其独有的渠道获得试验药物,这就限定了受试者只能从医生那里得到药物或治疗。而没有人符合Z=0且X=1这一假设就被称为单调性。【好像有点感觉,找不到具体定义】

例子表明,离开线性模型的世界,我们也并非束手无策。

自1984年以来,工具变量这一方法一直在发展演变,其中一个特别的衍生版本格外流行,该衍生版本被称为“孟德尔随机化”。

基因的例子,见原文

:star: 请记住,引入一个随机化的工具变量总是有益的。因为一旦经过了随机化处理,就不会有因果箭头指向它了。

从因果分析的角度来看,这两项研究给我们上了很好的一课:在做任何干预研究之前,我们都需要问,我们实际操作的变量(低密度脂蛋白的终生水平)是否与我们认为自己正在操作的变量(低密度脂蛋白的当前水平)相同。这正是我们先前提到过的“对自然的巧妙询问”的一种体现。

总而言之,工具变量是一个重要的工具,它能帮助我们揭示do演算无法揭示的因果信息。

而同样重要的是,相比工具变量,do演算具有更大的灵活性。因为在do演算中,我们不需要对因果模型中函数的性质做任何假设。

而如果我们的确有足够的科学依据证实类似单调性或线性这样的假设的话,那么像工具变量这种针对性更强的工具就更值得考虑。

工具变量方法的适用范围可以远远超越之前示例中的四变量模型,但是离不开因果图的知道。

在某些情况下,在对一组经过巧妙选择的辅助变量进行变量控制之后,我们就可以引入某个并不完美的工具变量(比如不满足独立于混杂因子这个条件),因为控制这些辅助变量可以阻断工具变量和混杂因子之间的路径。卡洛斯·布里托充分发展了这一将非工具变量转化为工具变量的思想,在其中一些情况中,我们还可以将一组变量成功地转化为一个工具变量来使用。

8. 反事实

——探索关于假如的世界

让我们回顾一下从第二层级中学到的知识。我们已经见识了几种方法,可以用于在各种情景设定和条件下确定干预的效果。

:随机对照试验、采集去混因子数据+后门调整、前门调整、工具变量(线性或单调性假设)、do演算或其衍生算法。

在所有这些努力中,我们的目标都是找到研究中处理的某个总效应或者在某些典型个体或子总体中的效应(平均因果效应)。但到目前为止,我们还不具备在特定事件或个体层面上谈论个性化的因果关系的能力。说“吸烟致癌”是一回事,而说“我的叔叔乔30年来每天抽一包烟,假如他不曾吸烟的话,那他现在可能还活着”就完全是另一回事了。

两者的区别既明显又深刻:像乔叔叔那样在吸了30年烟之后去世的人,是不可能在另一个他不曾吸30年烟的世界中被观察到的。

人类具有设想那个不存在的世界的能力,正是这一能力将我们与类人猿祖先以及地球上的其他生物区分开来。其他生物能看到“是什么”,而我们的天赋是能看到“假如……则本可能是什么”,当然,这种天赋有时也可能是一个诅咒。

本章的主要内容是讨论如何使用观察数据(第一层)和试验数据(第二层)来提取有关反事实情景的信息。我将具体解释如何在因果图的语境中表示个体层面的因,这项任务将迫使我们对此前尚未讨论过的因果图的一些具体细节做出解释。

还会介绍一个密切相关的概念,叫作“潜在结果”(potential outcomes)或奈曼—鲁宾因果模型。多年来,鲁宾一直坚持认为因果图没有任何用处。因此,信奉鲁宾因果模型的研究者往往困扰于缺乏一个工具用以表示因果知识或推导出可验证的蕴涵,我们将考察他们是如何在一片黑暗中解决因果问题的。

我将比较反事实在奈曼—鲁宾范式和结构因果模型中的定义,其中后者的提出公开地受益于因果图的独特优势。

还有针对被告罪责的证明,气候变化。

反事实分析能帮助气候学家给出比以前更精确的表述。不过,它要求我们适当增加一些词汇量。此外,我们还需要区分3种不同的因果关系:必要因果关系、充分因果关系以及充要因果关系(其中必要因果关系等同于“若非因果关系”。)

休谟为什么选择从反事实而非其他的角度来定义原因,这一点值得我们思考。定义的目的是对一个复杂的概念进行简化。

相比于“前一个对象引起后一个对象”这一定义,他的读者能够更清晰地理解“假如没有前一个对象,那么后一个对象就不可能存在”这句话。他说的很对。

前一句表述引发了种种徒劳的形而上学的猜想,即究竟是第一个事物的什么内在特质或能力引发了第二个事物。

在19世纪和20世纪的大部分时间里,哲学家忽略了休谟的第二个定义。反事实表述——“假如”(would haves)在研究者眼中总是显得过于软弱和不确定。因此,如第一章所述,哲学家开始尝试使用概率因果论来补救休谟的第一个定义。

和休谟一样,刘易斯显然也折服于这一事实:人类能够轻而易举、快速便捷和始终如一地做出反事实判断。我们可以自信地赋予反事实陈述一个真值和概率,就像我们对事实陈述所做的那样。

最重要的是我们的想象和判断要前后一致,这有助于我们在群体中达成共识。如果某人所认为的“更接近”的世界是另一个人认为的“更遥远”的世界,那么这两个人就肯定无法进行有效的反事实交流。从这一点上来看,刘易斯呼吁“为什么不从表面意义上看待反事实”并不是为了提出某种形而上学,而是为了引起人们对这一人类心理结构的惊人一致性的关注。

解释这种一致性:它源于这样一个事实,即我们体验的是同一个世界,并且共享因果结构的心理模型。共同的心理模型将我们团结在一起。因此,我们对于可能世界与现实世界相近程度的判断,并没有借助于“相似性”的某个形而上学的观念,而是借助于这样一个标准,即我们必须在多大程度上对我们共享的心理模型进行拆解和打乱,才能使其满足一个与事实(乔没有服用阿司匹林)相反的给定的假设条件。

我们处理干预do(X=x)的方式是一样的。我们可以将这种方法描述为:对因果图进行尽可能小的修改,以满足X等于x。在这方面,结构模型中的反事实定义符合刘易斯“与现实世界最相似的那个可能世界”的观点。

形上学是哲学的一个分支或范畴,被视为首要哲学和“哲学的基本问题”。对于不能直接透过感知所得到答案的问题,它在先验条件(可看成公理化的假设)下,透过理性的逻辑推理推演出答案,并且不能与经验证据相矛盾。它是人类理性对于事物最普遍的面相和终极的原因的探索的一门学科。

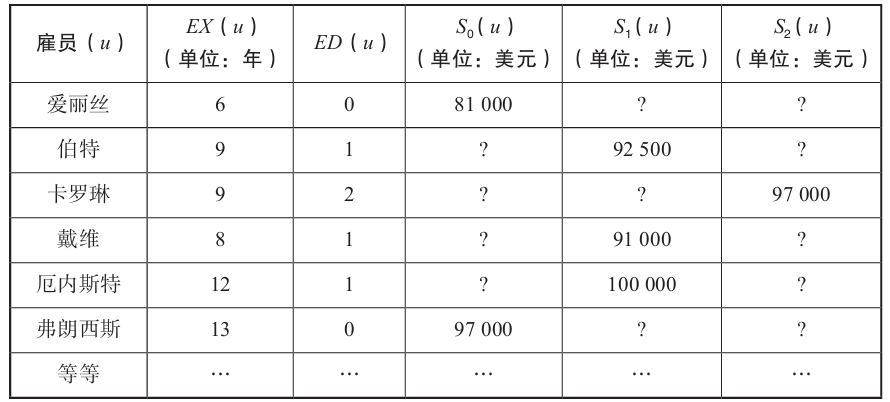

潜在结果、结构方程和反事实的算法化

在鲁宾的因果模型中,变量Y的一个潜在结果就是“假如X的值为x,那么Y在个体u上的取值”。

为方便起见,我们将这个量简写为$Y_X=x(u)$。如果从上下文中我们可以很明显地看出哪个变量被赋值为x,则我们通常会将这个表达式进一步缩写为$Y_x(u)$。

通过写下符号$Y_x$,鲁宾想要表明的是,假如X的值为x,那么变量Y一定会取某个与之相对应的值,其客观存在性与Y在现实中实际取的值相当。

注意,潜在结果,或反事实,是在个体层面而非总体层面上定义的。

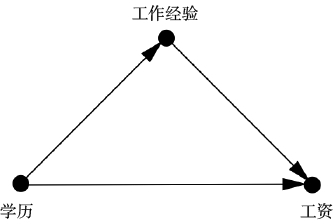

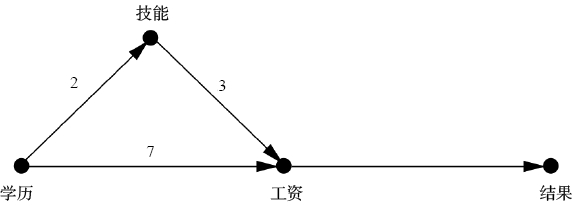

想要看一下决定员工工资的因素中,更重要的那个是学历(ED)还是工作经验(EX)。

对于同一个体,我们能观察到的潜在结果永远不会超过1个。

将因果推断问题看作一个数据缺失问题,可能会造成非常严重的误导。表8.1完全不涉及任何关于ED、EX和S的因果信息,例如是学历影响工资还是工资影响学历。更糟的是,即便我们已经掌握了一些关于这些变量的因果信息,这张表格仍然不允许我们把它们表示出来。

对于那些认为缺失数据就是“基本问题”的统计学家来说,这张表格似乎包含着无穷的可能性。的确,如果我们不把S0、S1和S2看作潜在结果,而看作普通变量,我们就能借助许多插值方法把空格填满

常见的推定方法是匹配,与控制变量(或数据分层)有着相同的思路:挑选共享某一观察特征的比较组,通过比较来推断它们看起来不共享的特征。遗憾的是,即使是世界上最具天赋的匹配者也不能将数据转化为潜在结果,连近似转化也不可能。我将在后文说明,真正的答案取决于是学历影响工作经验,还是反过来,工作经验影响学历,而这些信息在表格中是找不到的。

第二种可能的推断方法是线性回归,我们需要假设数据来自一些未知的随机源,然后使用标准统计方法来查找数据的最佳拟合直线(在本例中为平面)

$S=65000美元+2500美元×EX+5000美元×ED (8.1)$

这些插值方法看似无伤大雅,但它们本质上是有缺陷的。它们是数据驱动的,而不是模型驱动的。所有的缺失数据都是通过检查表格中的其他值来填充的。而正如我们从因果关系之梯中学到的,没有哪种纯粹基于数据的方法(第一层级)可以回答反事实的问题(第三层级)

如果我们的模型是错误的,比如EX其实是ED的一个因而不是反过来,那么工作经验就会变成一个混杂因子,此种情况下将具有类似工作经验的员工进行匹配就是完全恰当的。而如果ED就是EX的因,那么工作经验就是一个中介物。通过本书前文的介绍,你现在一定已经了解到,将中介物误认作混杂因子是因果推断中最致命的错误之一,很可能导致极为荒谬的错误结果。混淆因子要求统计调整,而中介物禁止统计调整。

“听从于”,用来表达因果图中的箭头。但现在是时候为这个概念添加一些数学内容了,这实际上就是结构因果模型与贝叶斯网络或回归模型的不同之处。

当我说“工资”听从于“学历”和“工作经验”时,我的意思是,工资是这些变量的一个数学函数:$S=f_S(EX,ED)$。但是考虑到个体差异,我们需要将这个函数扩展为$S=f_S(EX,ED,U_S)$,其中US代表“影响工资的其他未观测到的变量”。

假设我们所讨论的函数自始至终都是线性函数,让我们看看这一函数是怎样发挥作用的。我们可以使用统计方法来找到最佳拟合线性方程,该方程类似于方程8.1,但又存在一点区别:

:label:$S=65000美元+2500美元×EX+5000美元×ED (8.1)$

:label:$S=65000美元+2500美元×EX+5000美元×ED+US (8.2)$

方程8.1和8.2之间的形式相似性具有极大的欺骗性,实际上,对二者的解释存在天壤之别。我们在方程8.1中选择了求解S在ED和EX上的回归,绝不意味着在现实世界里S听从于ED和EX。这一选择纯粹是我们自己做出的(即按照习惯采用线性回归来进行插值),我们完全可以做出其他的选择,因为这张数据表格中没有任何规则能阻止我们转而求解EX在ED和S上的回归,或者其他形式的回归。

而一旦我们宣布一个方程是“结构的”,我们就失去了这种选择的自由。换言之,方程8.2的创建者必须承诺他所写出的方程真实反映了他所认定的关于现实世界中谁听从于谁的观点。在我们的例子中,作为方程的创建者,我确实相信S听从于EX和ED。更重要的是,模型中不存在方程$ED=f_{ED}(EX,S,U_{ED})$这一事实意味着我们认为ED对EX或S的变化不敏感。这种承诺或信念赋予了结构方程支持反事实假设的力量和否定回归方程的力量。

按照图8.3,我们还必须有一个关于EX的结构方程,但现在我们需要先将S的系数设为零,以反映从S到EX没有箭头这一图示信息。一旦我们从数据中估算出了具体系数,这个方程可能就如下所示:

:label: $EX=10–4×ED+U_{EX} (8.3)$

这个方程告诉我们,只有高中学历的员工的平均工作经验是10年,每增加一级学历(最多增加2级)将平均减少此人4年的工作经验。同样,请注意此结构方程和回归方程之间的关键区别:变量S不进入方程8.3<这同样反映了分析者的信念,即认为任何个体所获得的工作经验完全不受其当前工资水平的影响。

让我们演示一下如何从结构模型中推导反事实。假如爱丽丝有大学学历,为了估计她的工资水平,我们需要执行以下3个步骤:

(1.外展)利用关于爱丽丝和其他员工的数据来估计爱丽丝的特质因子(idiosyncratic factors):$U_S$(爱丽丝)和$U_{EX}$(爱丽丝)。

(2.干预)利用do算子改变模型,以反映我们提出的反事实假设,在这个案例中即,假如爱丽丝有大学学位:$ED$(爱丽丝)=1。

(3.预测)利用修改后的模型及有关外生变量(exogenous variables)的更新信息$U_S$(爱丽丝)、$U_{EX}$(爱丽丝)和$ED$(爱丽丝)来估算爱丽丝的工资水平。新的工资水平就等于$S_{ED=1}$(爱丽丝)。

对于步骤1,我们可以从数据中观察到EX(爱丽丝)=6,ED(爱丽丝)=0。我们将这些值代入方程8.2和8.3,便得到爱丽丝的特质因子:US(爱丽丝)=1000美元,UEX(爱丽丝)=–4。这两个值代表了关于爱丽丝的独一无二的一切。不管它们具体是什么,总之,它们将她的预测工资增加了1000美元。

步骤2告诉我们要用do算子删除指向被赋予了反事实值的变量(学历)的箭头,并将爱丽丝的学历设置为大学学历(学历=1)。在此例中,步骤2可以省略。

最后,步骤3表示的是更新模型以反映新的信息,US=1000美元,UEX=–4,ED=1。首先,我们使用方程8.3重新计算“假如爱丽丝上了大学”的情况下,她的工作经验:EXED=1(爱丽丝)=10–4–4=2年。然后我们用方程8.2计算她的新的工资水平:

$S_{ED=1}(爱丽丝)=65000美元+2500美元×2+5000美元×1+1000美元=76000美元$

世上没有免费的午餐,我们能得到这一强有力的结果是因为我们做出了强有力的假设。除了断定观察到的变量之间的因果关系,我们还假设了函数关系是线性的。

事实上我们并不总能获得这些函数信息。一般而言,如果箭头背后的函数是已知的,则我们称该模型为“完全指定的”,否则就是“部分指定的”。如果模型是部分指定的,我们可能就无法准确地估计出爱丽丝的工资水平,而是需要用一个概率区间作为对潜在结果的表述,例如“她的潜在工资有10%到20%的可能为76000美元”。对许多实际应用方面的案例而言,这样的概率答案已经足够好了。此外,即使我们不知道关于箭头背后的特定函数的信息,或者只知道像上一章提到的“单调性”假设这类非常笼统的信息,我们仍然能够从因果图中提取足够多的信息。

与透明性密切相关的一个概念就是可测试性,这一概念在本书中已经出现过几次。我们可以很容易地测试出以因果图为基础建立的模型与数据的兼容性,而以潜在结果的语言为基础所建立的模型就没有这个特点。

响应函数是赋予结构因果模型处理反事实的能力的关键因素。是结构因果模型与贝叶斯网络(包括因果贝叶斯网络)的一个主要区别点。在概率贝叶斯网络中,给定Y的父变量的观测值,则箭头指向Y就表示Y的概率由Y的条件概率表所支配。因果贝叶斯网络也是如此,不同之处在于给定的是对父变量的某种干预。

两种模型都指定了Y的概率,而非指定Y的取值。而在结构因果模型中,我们没有条件概率表,指向Y的箭头只简单地表示Y是其父变量和外生变量UY的一个函数:

$Y=f_Y(X,A,B,C,…,U_Y) (8.4)$

要让其能够回答反事实的问题,我们需要在每个节点上建立剂量—响应关系。

结构方程模型(SEMs)与结构因果模型(SCMs)的另一个重要区别是,结构因果模型中的因果关系不一定是线性的。结构因果模型分析所用到的方法对非线性函数、线性函数和离散变量、连续变量同样有效。

线性结构方程模型具有许多明显的优点和缺点。一方面,从方法论的角度看,它们非常简单。通过线性回归,我们可以直接从观测到的数据中估计因果效应,而且目前已有许多针对此类模型的统计分析软件包可供我们选择使用。

【如后文所叙,线性因果模型不允许变量之间发生交互。】

如果我们有一个完全指定的结构因果模型,其包含一张因果图且箭头背后的所有函数都是已知的,我们就可以回答任何反事实的问题。即使我们只有部分指定的结构因果模型,其中的一些变量是隐藏的或其中的一些剂量—响应关系是未知的,在许多情况下我们仍然可以回答关于反事实的问题。

我们应该怎样用潜在结果表达必要因或“若非因”?如果我们用结果Y表示“朱蒂的死亡”(假如朱蒂活着,Y=0;假如朱迪死了,Y=1),行为X表示“乔堵住消防通道”(假如他没堵住,X=0;假如他堵住了,X=1)。我们要问的是以下这个问题:

已知乔堵住消防通道(X=1),并且朱蒂死了(Y=1),假如X为0,那么朱蒂还活着(Y=0)的概率是多少?

我们想要评估的概率可以用符号表示为$P(Y_{X=0}=0|X=1,Y=1)$。这个表达式相当烦琐,我在接下来会将它缩写为“PN”(probability of necessity),即必要性概率

必要性概率涉及两个不同的世界之间的对比:X=1的现实世界和X=0(用下标X=0表示)的反事实世界。

事实上,是否有事后判断(知道现实世界中发生了什么事情)是反事实和干预之间的关键区别。没有事后判断,$P(Y_{X=0}=0)$和$P(Y=0|do(X=0))$之间就没有区别,都表示在正常情况下,如果我们确保消防通道没被堵住,朱蒂就不会死;两个方程都不涉及火灾、朱蒂的死亡或被堵住的消防通道。

但事后判断可能会改变我们对概率的估计。

do表达式无法捕捉$P(Y_{X=0}=0|X=1,Y=1)$。虽然具体的论证过程可能有些晦涩难懂,但这一结论的确提供了一个数学上的证明,即在因果关系之梯中,反事实(第三层级)要高于干预(第二层级)

使用反事实符号,我们可以定义充分性概率或PS(probability of sufficiency)为$P(Y_{X=1}=1|X=0,Y=0)$

充分因在两者中更加常见,在第一章的行刑队执行枪决的例子中,我们已经遇到了这个概念。在那个例子里,士兵A或士兵B无论哪个开枪都足以造成囚犯死亡,而且两个士兵(自身的行为)都不是必要因。所以对于这个例子,PS=1且PN=0。

当出现不确定因素时,事情就会变得有趣起来,例如,我们可以假定每个士兵都有可能不服从命令或射失目标。如果士兵A射失目标的概率是pA,那么他的PS将是1–pA,这是他击中目标并造成犯人死亡的概率。而他的PN将取决于士兵B有多大可能拒绝开枪或者射失目标。士兵A的射击是必要因,仅限于士兵B不开枪或射失目标这种情况,即在此种情况下,假如士兵A不开枪,那么犯人还将活着。

如果我们考虑到某个人划火柴的概率远远低于氧气存在的概率,那么经过量化,我们就可以发现,对于划火柴来说,其PN和PS都很高,而对于氧气来说,其PN很高,但PS很低。这就是为什么我们直觉上会将火灾归咎于划火柴而非氧气,而这很可能只是答案的一部分。

从人工智能的角度来看,显然PN和PS应该被纳入生成解释的过程。当一个机器人被要求解释火灾发生的原因时,它别无选择,必须同时考虑这两个方面的因素。只关注PN会导致它得出一个站不住脚的结论,即火柴和氧气对火灾的解释同样充分。而给出这种解释的机器人很快就会失去主人的信任。

随着时间的延长,温室气体的PN会逐渐降低,因为可能会出现其他引发异常天气事件的机制。而温室气体的PS则逐渐升高,因为我们实际上在不断增加看到同样结果出现的可能。

当我们将反事实纳入考虑后,我们向“因果推断引擎”提出的因果问题的多样性和丰富性就会大大增强。一个非常流行但我们还没有讨论过的问题是“参与者处理效应”(effect of treatment on the treated,简称为ETT)问题,这种效应是用来评估获得处理的人是否是能从该处理中受益最多的人。

在许多情况下,这一测度要优于对处理有效性的常规测量——平均因果效应(average causal effect,简称为ACE)。你可以从随机对照试验中得到ACE,它是整个总体的平均处理效应。

毫无疑问,在当今的科学界,反事实方法最受欢迎的一种应用形式就是“中介分析”(mediation analysis)。中介分析的目的是将直接效应(未通过中介物介异)从间接效应(通过中介物介导)中解析出来,其重要性显而易见。

为此,我将用单独的一章来介绍它。

在科学语境中,中介物(mediator)或中介变量(mediating variable)指的是将处理效应传递给结果的事物。我们已经在本书中看到了许多有关中介的例子,比如,吸烟→焦油沉积→癌症(其中焦油沉积是中介物)。在这些例子中,人们感兴趣的主要问题是,中介变量是否解释了处理变量的全部影响,或者处理变量的部分效果是否可以不通过中介物传递给结果。我们一般会用一个直接从处理指向结果的箭头来表示这种效应,比如,吸烟→癌症。

9. 中介

——寻找隐藏的作用机制

“为什么”这个问题至少有两个版本。第一个直截了当:你看到一个果,想知道因。

“为什么”还有第二个版本,在这个版本中,我们提出这个问题是为了更好地了解已知的因和已知的果之间的联系

科学家使用“中介”(mediation)这个词来表达第二个版本的“为什么”。

(对于原因A抑制了结果B这种情况,生物学家通常会使用一种不同的符号A┤B来表示,但在因果论文献中,A→B通用于表达肯定的因和否定的因。)

我们需要具备一种敏锐的判断力,以区分总效应、直接效应(不通过中介物)和间接效应(通过中介物)

对我来说,定义中介这一概念曾经也是一个难题,而对这一难题的攻克最终成为我职业生涯中最有价值的收获之一,因为我在一开始的时候犯了错,而当我从错误中吸取了教训之后,我得以想出了一个意想不到的解决办法。有一段时间,我曾认为间接效应不具备任何操作性意义,因为它与直接效应不同,不能用干预的语言来定义。而当我意识到我可以通过反事实来定义它们,并且它们也具有重要的策略意义时,我的研究便取得了一次重要的突破。只有在我们到达了因果关系之梯的第三层级,我们才可能量化它们,这就是为什么我把它们放在本书的末尾部分。

在过去的15年中,因果革命为学界提供了一套明确而简单的规则,用以量化一个给定效应中直接效应和间接效应所占的比例。它将中介从一个不为人知的、合法性备受质疑的概念,转变为一个广受欢迎、普遍适用的科学分析工具。

以中介物为条件(对中介物进行变量控制),而不是保持中介物恒定(设其为常量)。我称其为中介谬误(mediation fallacy)。诚然,如果中介物和结果之间没有混杂,则这个错误并无实际危害。然而,如果确有混杂,那么这一错误完全可以反转分析结果

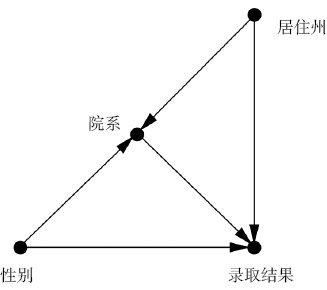

比如该图中的“院系”中介变量。

该问题可用do演算解决。

直接效应:受控vs自然

我们首先考虑一个只包含3个变量的最简单的案例:处理X,结果Y,中介物M。当我们“扰动”X而保持M恒定时,我们就得到了X对Y的直接效应。

该结果也被称为“受控直接效应”(controlled direct effect,简称为CDE),可以用符号表示为CDE(0):

$CDE(0)=P(Y=1|do(X=1),do(M=0))–P(Y=1|do(X=0),do(M=0)) (9.1)$

“0”在CDE(0)中表示的是我们迫使中介物取值为0。

过度对照试验:

设想有一个名叫乔的申请人,他的毕生梦想是学习工程学,而他碰巧(随机地)被分配去申请历史系。在和招生委员会面谈几次之后,我敢保证,对委员会来说,乔的申请看起来会非常奇怪。

相比申请人按照自己的意愿正常申请历史系的情况,在这种失真的情境中,男性和女性的录取比例很难反映出实际的招生政策。

避免踏入这个“过度对照试验”的陷阱。我们指示申请人随机报告性别,但允许他们按照自己的意愿申请他们==本来就==青睐的院系。我们将由此得到的直接效应称为“自然直接效应”(natural direct effect,简称为NDE),因为每个申请人最终都会申请他自己选择的院系。

“本来就”这样的措辞暗示NDE的正式数学定义需要反事实。

该定义可表示为如下公式:

$NDE=P(Y_{M=M0}=1|do(X=1))–P(Y_{M=M0}=1|do(X=0)) (9.2)$

在此例中,NDE代表的是如果想申请$M_0$院系的一个女生将她的性别报告为“男性”,即do(X=1),其申请自己想去的院系(M=M0)的录取概率。在这里,院系的选择是由真实的性别决定的,而录取是由报告的性别(假性别)决定的。

如何计算受控直接效应和自然直接效应:

对于受控直接效应,这项任务很简单,因为它可以表示为一个do表达式,所以我们只需要使用do演算定律将do表达式精简(转化)为see表达式(可从观测数据中直接估计出的条件概率)即可。

估计自然直接效应则是一个更大的挑战,因为它不能用do表达式来定义。它需要我们调用反事实的语言,因而我们也不能用do演算来估计它。这一重要成果被作者称为“中介公式”(Mediation Formula),它使NDE成为一种真正实用的工具,因为我们再一次实现了从观测到的数据中将其直接估计出来这一目标。

间接效应

与直接效应不同的是,间接效应没有“受控”版本的定义,因为我们无法通过保持某些变量恒定来关闭直接路径。但它确实有一个“自然”版本的定义,自然间接效应(natural indirect effect,简称为NIE),且该定义同NDE一样需要调用反事实的语言。

一个例子

我们设法重建的是,假如小猫不在场,同时假如我们将中介物的值设置为小猫在场时的值,那么本应该发生的事是什么。换句话说,我们移走了小猫(干预1),并像小猫在家时那样监督黛西(干预2)

其中提到了两个“假如”,这是反事实语言。不过,这个定义实际上非常符合我们对因果关系的自然直觉。

$NIE=P(Y_{M=M1}=1|do(X=0))–P(Y_{M=M0}=1|do(X=0)) (9.3)$

第一个P是黛西试验的结果:假设我们不引入其他宠物(X=0),但将中介物设置为引入其他宠物时会有的值(M=M1),此时黛西的行为有所改善(Y=1)的概率。我们将它与“正常”条件(没有其他宠物)下黛西的行为有所改善的概率进行对比。

若假设M和Y之间没有混杂,则自然间接效应仍然是可以计算出来的。从NIE中删除所有的反事实下标,我们就能得到一个中介公式。

启示:只需要设定中介物的值,就能推测出另一个因果机制(也就是间接因果)。

线性“仙境”

$总效应=直接效应+间接效应 (9.4)$

为什么不能用👆来表示间接效应呢?该定义在涉及变量间的相互作用(有时也被称作“调节作用”)的模型中行不通。

【个人idea,这个调节作用是不是也值得研究一下呢,比如找到一个“不变量”?】

比如,设想一种药物,它能促使身体分泌一种起到催化剂作用的酶,这种酶在与药物结合后可以治疗某种疾病。药物的总效应当然是正的。但直接效应是零,因为如果我们让中介物失效(比如阻止这种酶的生成),则药物就无法起作用。间接效应也是零,因为如果我们不服用药物,仅通过人工手段刺激人体生成这种酶,那么疾病仍然无法得到治愈,因为酶本身没有治疗功效。因此,在此例中方程9.4不成立:总效应是正的,但直接效应和间接效应都是零。

然而,在一种特殊的情况下,方程9.4将自动成立,且无须调用反事实。

这就是我们在第八章看到的线性因果模型的例子。如前文所述,线性模型不允许变量之间的交互,这一限定有利有弊。利的一面是,它使中介分析变得容易了许多。弊的一面是,如果我们想描述一个涉及交互的实际存在的因果过程,它就不再适用了。

在上图的例子中,如果处理增加一个单位,结果会增加$7(直接)+2*3(间接) = 13$个单位的量。

1986年,鲁本·巴伦和大卫·肯尼阐述了一套在方程组中检测和评估中介效应的原则。

首先,这些变量都是通过线性方程相关联的,我们可以利用数据拟合来构建回归方程。其次,直接效应和间接效应是通过两个回归方程计算出来的,其中一个包含中介物,另一个不包含中介物。当引入中介物时,相对于无中介物的方程,系数的显著变化就被视为中介效应存在的证据。这篇论文被引用的次数比阿尔伯特·爱因斯坦提出相对论的论文、比西格蒙德·弗洛伊德提出精神分析的论文还要多

这其中发生的一个巨大飞跃——一个因果量(中介效应)可以通过纯粹的统计学方法来定义和计算。

研究者试图将乘积之和的规则推广至非线性系统。这一规则涉及两个假设

——不同路径的效应是可累加的,

——一条路径涉及的效应(路径系数)是可相乘的,而这两个假设在非线性模型中都不成立。

在离开线性仙境之后,我们此前的假设将导致严重的错误。如下图所示👇

其中求职者当且仅当预期工资超过某一阈值(此例中阈值为10)时才会决定接受工作。

确定技能和工资的函数仍假设为线性的,而工资与结果的关系是非线性的,因为它涉及一个阈值效应。

记住,自然间接效应指的是结果的预期变化,假设我们对“学历”不做任何改变,而将“技能”设定为在“学历”提高了一个水平的前提下其所应该有的水平。很容易看出,在这种情况下,“工资”将从0变为2×3=6,低于阈值10,所以求职者不会接受这份工作,因而NIE=0。

直接效应呢?如前所述,我们遇到的问题是要弄清楚中介物应该取什么值。一方面,如果我们采用“学历”水平改变之前的“技能”水平,那么“工资”将从0增加到7,低于阈值,使“结果”等于0。因此,CDE(0)=0。另一方面,如果我们采用“学历”改变后(学历=2)的“技能”水平,那么“工资”将从6增加到13,这将使“结果”从0变为1。所以CDE(2)=1。

此时就崩了,线性的相加性原则失效。

只需要对原来的相加性原则进行一次微调,我们就能重新让其在本例子中成立,不仅在本例中,在一般的情况下我们也可以这样做。

总效应$(X=0→X=1)=NDE(X=0→X=1)–NIE(X=1→X=0)$

如果我们把计算从$X=1$转变为$X=0$,那么“工资”会从13降到7,“结果”从1降至0(求职者不接受此工作)。所以按照这一反方向(从X=1转变为X=0)来计算,NIE=–1。

代入这个例子中的具体数值,就是1=0–(–1)。这就是相加性原则的“自然效应”版本,只不过它其实是一个相减性原则!(好家伙)

人们花费了大量笔墨阐述如何正确地根据线性模型的直接效应和间接效应的计算方法推导出非线性模型的直接效应和间接效应的计算方法。遗憾的是,试图解决这个问题的大多数文章都在拖后腿。研究者没有从头开始,重新思考我们所说的直接效应和间接效应,而是假设我们只需要微调线性模型下两者的定义即可。

其实,在线性模型之外,间接效应对回归分析来说就不再有意义了,其仅剩的意义就是代数步骤的结果(“路径系数的乘积”)。一旦撤走步骤本身,它们就会像一艘没有锚的小船一样随波逐流。

回信:“保持X恒定,并将M增加到X增加1个单位的情况下M所能达到的量,则我们所看到的Y的增量就是X对Y的间接效应。

拥抱“假如”世界

艾滋病的治疗通常要历经数年,后续治疗方案的实施取决于病人体内的CD4细胞数。治疗包含许多阶段,而所有的中介物(你可能想控制这些变量)都取决于上一个治疗阶段,在这种情况下你如何对治疗的因果效应进行区分呢?

作者与他人合作提出了序贯后门标准,作者还发现两个行动有时比一个更容易分析,因为行动对应于删除图上的某些箭头,两个行动可以让图示变得更稀疏,更简单。

我们提出的序贯后门标准可以用于分析包含大量do演算的长期处理(治疗)。后来才开始研究中介分析,还有间接的效应这些。

现在回想起来,我当时是被do演算的成功蒙蔽了双眼,它让我盲目地相信,关闭一条因果路径的唯一方法就是取一个变量,将其设置为一个特定值。但事实并非如此。如果我有一个因果模型,通过命令谁何时以及如何听从于谁,我有许多创造性的方式可以用来操纵模型。

具体而言,我可以固定主要变量的值以抑制其直接效应,还可以同时假设在主要变量被激活的情况下,赋予中介物一个值以传递主要变量的影响。这使我可以让处理变量(如小猫)取值为0,并将中介物的值设置为处理为1时的值。然后,我的数据生成过程模型就可以告诉我如何计算独立于干预的中介效应。

像是一个直观上的概括:

对于直接效应,针对每个个体,我们让中介物“自行选择”在无处理时它本应该有的值,并将其固定在这个值上。现在,我们“扰动”处理变量并记录其所引起的结果的差异。

这与我前面讨论过的受控直接效应不同,在后者中,每个个体的中介物都被固定为同一个值,该操作对于所有个体一视同仁。而在这里,因为我们让中介物自行选择它的“自然”值,因此我称之为自然直接效应。

类似地,对于自然间接效应,首先,对每个个体我不予处理,然后针对每个个体,我让中介物“自行选择”有处理时它本应该有的值。最后,我记录两个结果的差异。

当我们把反事实引入以后,发现它们也可被装入数学公式,我们将拥抱这个“假如”世界

中介公式

这个公式能告诉你如何根据观测数据估计自然直接效应和自然间接效应,以及它适用于何种情况。

该公式对X、M、Y之间关系的具体函数形式不做任何假设。

$NIE=∑m[P(M=m|X=1)–P(M=m|X=0)]×P(Y=1|X=0,M=m) (9.5)$

中括号内的表达式代表X对M的影响,乘号后的表达式代表M对Y的影响(当X=0时)。

与方程9.3不同,方程9.5没有下标和do算子,因此其结果可以直接根据第一层级的数据估计出来。

在这个公式中,我可以一目了然地看到有关直接效应和间接效应的一切:使它们变大或变小都需要什么,什么时候我们可以从观察或干预数据中估计它们,什么时候我们可以认为一个中介物要对将观察到的变化传递给结果变量这件事“负责”。

在过去,为讨论这些例子,我们必须对每一种情况采用不同的方式进行处理。而现在,我们只需要一个公式就足够了。

我们甚至可以计算出总效应中的哪些可以由中介变量来解释(explained),哪些是由中介变量引起的(owed to)——这是两个相互补充的概念,而在线性模型中,二者重叠为一。

在人们终于确认了非线性中介分析完全可行之后,该领域的研究便突飞猛进地发展起来。如果你去学术文章的数据库搜索标题中包含“中介分析”这一关键词的论文,你会发现在2004年之前,这样的论文几乎不存在。而2004之后的第一年就出现了7篇论文,然后是10篇、20篇,现在每年都超过100篇。我想以接下来的三个例子来结束本章,希望用这些例子来说明中介分析的各种可能性。

:star: 中介分析特别适用于评估副作用的影响。

10. 大数据,人工智能和大问题

【没看懂】

一个新的范式正在逐步发展成形,根据这个范式,你可以在假设的基础上提出你自己的主张,只要你的假设足够简明易懂,大家就可以判断出你的主张的可信度,以及面对反驳的脆弱度。

因果革命也许没有带来能直接改变我们生活的特定工具,但它在整个科学界引起的态度转变,必然有利于科学的蓬勃发展。

我们真的离计算机或机器人能够理解因果对话的时代越来越近了吗?我们真的能制造出像三岁孩童那样富有想象力的人工智能吗?在最后一章,我将分享我个人的一些想法,我不会给出一个明确的结论,而是更希望留给大家思考的空间。

:star: 某些领域存在着一种对数据的近乎宗教性的信仰。这些领域的研究者坚信,只要我们在数据挖掘方面拥有足够多的智慧和技巧,我们就可以通过数据本身找到这些问题的答案。然而,本书的读者已经明白,这种信仰是盲目的,很可能受到了对数据分析的大规模宣传炒作的误导。我刚刚问的问题都是因果问题,而因果问题从来不能单靠数据来回答。它们要求我们建构关于数据生成过程的模型,或者至少要建构关于该过程的某些方面的模型。当你看到一篇论文或一项研究是以模型盲的方式分析数据的时候,你就能确定其研究结果最多不过是对数据的总结或转换,而不可能包含对数据的合理解释。

这并不是说数据挖掘没有用。对于探索我们感兴趣的关联模式,并据此提出更精确的解释性问题,数据挖掘很可能是关键的第一步。

数据挖掘帮助我们筛选出高度相关的因素,然而,要想更进一步,我们就需要建立一个因果模型,用以说明我们所认为的某个基因其可能影响的变量有哪些,可能存在的混杂因子是什么,以及其他的因果路径可能带来的种种后果。解释数据就意味着做出一种假设,这种假设建基于事物在现实世界中的运作方式。

大数据在因果推断问题中的另一个作用体现在因果推断引擎的最后阶段,我们在前言中描述过这一阶段(步骤8),它让我们得以借助被估量推导出估计值。当变量较多时,统计估计这一步的难度不可小觑,只有借助大数据和现代机器学习技术,我们才有可能真正应对维度灾难。

有些人将数据挖掘看作研究的终结而不是第一步,原因很容易理解。它允许我们使用现成的技术得出一个解决方案,让我们以及未来的机器不必费力去考虑和阐明关于现实世界运作方式的实质性假设。但在某些领域,我们的知识还处在初步积累的阶段,因此我们不知如何下手去建构一个关于该领域的模型。而大数据无法帮助我们解决这一领域的问题,因为此类问题的答案的主体部分必然来自模型,无论这个模型是由我们自己构建出来的,还是由机器假设并微调出来的。

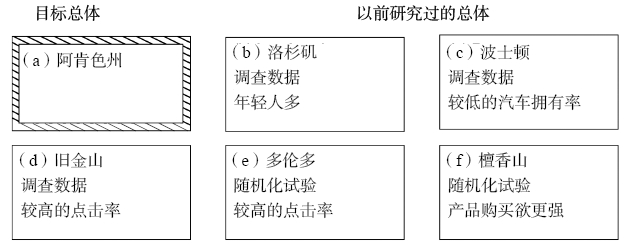

我想为大数据和因果推断的合作提供一个新机会,我将这一新机会称为“可迁移性”(transportability)

得益于大数据,我们不仅可以在任何特定的研究中获得大量个体的数据,还可以接触到大量在不同地点和不同条件下进行的研究。我们常常希望将这些研究结果结合起来,然后将其迁移至一个新的总体,这一新的总体可能在各种我们意想不到的方面与原始研究中的总体有所不同。

伊莱亚斯·巴伦拜姆成功地提出了一个完整的标准用以判断研究结果何时是可迁移的,何时是不可迁移的。与以往一样,使用此标准的前提条件是,你已经使用因果图表示出了数据生成过程的显著特征,并且标记出了潜在的差异点。“迁移”一个结果并不一定意味着取其表面意义,将之直接应用到新的环境中。考虑到新旧环境之间的差异,研究者可能不得不需要重新校准旧的研究结果。

目前计算机已具备处理这一复杂的“数据融合”问题的能力。在do演算的指导下,计算机能告诉我们可以使用哪些已有的研究、借助哪些手段来回答问题,以及在阿肯色州收集哪些变量的数据可以用来支持我们的结论。在某些情况下,效应可以直接迁移,我们不需要再做额外的工作,甚至无须踏入阿肯色州就可以得到结论。

在一些案例中,我们无法将任何一项以往的相关研究所得出的效应迁移过去,但我们可以从这些效应的某种形式的组合中估计出目标总体的效应。

在简单的情况中,我们用直觉就可以判断出这些结果是合理的,但当图表变得更加复杂时,我们就需要一种形式化的方法来辅助我们做出判断。对此,do演算提供了一种确定可迁移性的一般标准。该规则非常简单:如果你可以执行一系列有效的do演算(运用第七章中的规则),将目标效应的表达式转换为一个新的表达式,其中任何涉及S的因子都不包含do算子,则这一估计值就是可迁移的。其遵循的逻辑很简单:任何此类因子都可以从现有数据中估计出来,且不受差异因子S的影响。

我们不再将总体之间的差异视为对研究的“外部有效性”的威胁,而是掌握了一种有效的方法,得以在之前看似无望的情况下确立有效性。正是因为生活在大数据时代,我们才有机会接触到关于诸多研究和辅助变量(如Z和W)的信息,从而能够将已有的研究结果从一个总体迁移至另一个总体。

目前,对“外部有效性”的研究完全专注于对效度威胁的罗列和分类,而不是与之做斗争。

顺便一提,针对另一个长期困扰统计学家的问题——选择偏倚,巴伦拜姆也得出了类似的结论。当研究的样本与目标总体在某些相关方式上不一致时,这种偏倚就会出现。这听起来很像一个可迁移性问题——的确如此,只不过我们需要先做一个非常重要的修正:我们要绘制一个指向S的箭头,而不是绘制一个从指示变量S指向受影响变量的箭头。在此例中,我们认为S代表的是“研究选择”。

例如,在伯克森偏倚的例子中,如果我们的研究只以住院患者为观察对象,那么我们就相当于画了一个从住院治疗指向S的箭头,其表明住院是我们的研究选择的一个因。在第六章,我们曾将这种情况仅仅视为对研究有效性的威胁。但现在,我们可以再次把它看成一个机会。如果我们掌握了选择的机制,我们就可以为我们的研究补充受试者,或者收集正确的去混因子数据集,并通过适当的重新加权或公式调整来克服偏倚。巴伦拜姆的工作让我们可以利用因果逻辑和大数据创造出以前无法想象的奇迹。

AI

人工智能的研究因过于强调基于规则的系统而受到了制约。但事实证明,基于规则的系统是错误的,它们十分脆弱,对其运行假设的任何细微改变都会导致我们必须重写整个系统。这些系统不能很好地应对不确定性或矛盾的数据。此外,这些系统缺乏科学意义上的透明性:你无法在数学上证明它们会按照某种方式运行,而如果运行不当,你也无法精准地指出什么地方需要修改。

贝叶斯网络是概率的,它可以应对充满矛盾和不确定数据的世界。而基于规则的系统则不同,它们是模块化的,易于在分布式计算平台上编码,这让它们运行得很快。贝叶斯网络以数学的方式可靠地处理概率,这就保证了即便出了什么差错,该差错也只会出现在程序中,而不会出现在我们的思想里。

事实上,贝叶斯网络甚至无法解释“因果方向”是什么。

有些人可能会说,我们并不真正需要透明。毕竟我们也不太明白人脑是如何工作的,但它的确运行良好,而我们也原谅了自己对于大脑运行机制的肤浅理解。因此,他们指出,为什么不可以在不了解工作原理的情况下将深度学习系统解放出来,创造一种新的智能?我不能说他们错了。此时此刻,“将就派”的确抢占了先机。但我至少可以说,我个人不喜欢模糊的系统,这就是我不研究此类系统的原因。【哈哈】

不过,我确实对深度学习的一个方面感兴趣,即其系统的理论局限性,其中最主要的局限体现在其无法超越因果关系之梯的第一层级。深度学习系统探索的是洞穴壁上的那些阴影,学习的是准确预测阴影的活动。深度学习系统不能理解它观察到的阴影仅仅是三维物体的空间运动在二维平面上的投影,而强人工智能必须具备这种理解力。

使用机器学习的经济学家注意到,这一方法不能帮助他们回答他们真正感兴趣的关键问题(确实,从来没想过机器学习能干这些事情),例如估计尚未实施的策略和行动的影响。典型的例子包括预测推行新的价格结构、补贴政策或调整最低工资的影响。从技术的角度看,今天的机器学习的确是一种有效方法,它让我们得以通过有限的样本估计总体的概率分布,但我们仍然需要在此基础上根据分布推测因果关系。

任何关于意图的讨论都将涉及强人工智能的另一个重要问题:自由意志。如果我们要求机器首先产生做X=x的意图,然后在觉察到自己的这个意图之后,反而选择去做X=x’,我们就相当于是在要求机器拥有自由意志。但是,如果机器人只会遵循存储在程序中的指令,那么它如何才能有自由意志呢?

随着科学的进步,许多哲学问题已经消失了,而自由意志仍然保持着当初的神秘

哲学起来了👇

并非所有的哲学家都相信自由意志和决定论之间存在冲突。还有一派被称作“兼容并包者”(我自己就是其中一员),他们认为二者只是在描述的两个不同的层面时存在明显的冲突:一是神经层面,在这一层面,过程看起来是决定性的(暂且不考虑量子不确定性的问题);二是认知层面,在这一层面,我们能体验到生动的自主选择的感觉。这种明显的冲突在科学中并不少见。例如,物理方程在微观层面上具有时间可逆性,但在描述的宏观层面上则显得不可逆转,比如烟雾永远不会回流到烟囱里。但这又引发了新的问题:假设自由意志是(或者可能是)一种幻觉,那么为什么对我们人类来说,拥有这种幻觉如此重要?为什么进化过程不辞辛劳地赋予我们这个概念?不管是不是在制造噱头,我们是否都应该尝试着给下一代计算机编写程序,让它们拥有这种幻觉?这样做的目的何在?它带来了哪些计算优势?

我认为,理解自由意志幻觉的功能是解开它如何才能与决定论相调和这一深奥谜题的关键。而一旦我们赋予一台确定性机器同样的功能,问题就会迎刃而解。

除了功能问题,我们还必须处理模拟问题。

如果是大脑中的神经信号引发了我们所有的行动,那么我们的大脑就一定会忙于用“意志”或“有意”来美化某类行动,而用“无意”来美化另一类行动。这个贴标签的过程到底是什么?什么样的神经路径会得到带有“意志”标签的特定信号?

在许多情况下,人的自发行为都被认为会在短期记忆中留下痕迹,这个痕迹就反映了背后的目的或动机。例如,“你为什么这么做?”“因为我想打动你。”或者,就像夏娃在伊甸园给出的回答:“蛇欺骗了我,我就吃了。”但在许多其他的情况下,我们采取了有意的行动,却没有什么理由或动机。对行动的合理化可能是一个事后重建的过程。

例如,一个足球运动员也许能够解释为什么他决定把球传给乔而不是查理,但这些原因几乎不可能有意识地触发了他的这一行动。在球赛最激烈的时候,数以千计的输入信号都在抢占运动员的注意力。我们要做出的关键的决定是哪些信号需要优先处理,而决定背后的原因往往很难回忆和阐明。

总之,我认为,能够给思维机器带来智能体效益的软件包至少包括3个组成部分:关于世界的因果模型;关于自身软件的因果模型,无论这个模型有多浅显;以及一个内存,用于记录其心理意图对外部事件的反应方式。

在精神层面,构建道德机器的因果方法与20世纪50年代以来科幻小说所热衷讨论的方法,即阿西莫夫的机器人定律,有着很大的不同。阿西莫夫的定律总是会导致矛盾。对人工智能科学家来说,这并不奇怪:基于规则的系统最终总会出错。但这并不能说明制造道德机器就是不可能的,而是意味着我们不能使用规范性的、基于规则的方法去制造它,意味着我们应该为会思考的机器配置人类所拥有的那些认知能力,包括共情、远期预测和自制力,这样,它们就能够做出自己的决定了。

一旦我们制造出了道德机器,许多杞人忧天的观点就会随之消失,变得无关紧要。我们没有理由不去制造这种能比人类更好地分辨善与恶、抵御诱惑以及权衡奖惩的机器。

在未来,我们可以依靠机器来寻求明察秋毫、因果合理的正义,我们将进一步了解人类自身的自由意志“软件”是如何运作的,以及它是如何对人类自身隐藏其工作原理的。这种会思考的机器将成为人类的良师益友,而这正是人工智能送给人类的第一份,也是最好的一份礼物。